У світі хмарних сервісів та штучного інтелекту дані стрімко перетворюються на найцінніший актив для будь-якого бізнесу. Як розпоряджатися цим активом розумно? На допомогу приходять рішення Data Science, що об’єднують статистику, машинне навчання та алгоритми обробки даних для видобутку знань з величезних обсягів інформації.

У цьому матеріалі ми поговоримо про типи та етапи розробки data science рішень. Розберімось, як застосувати передові технології обробки даних для вирішення практичних завдань бізнесу.

Що таке Data Science рішення?

Data Science – це не зовсім наука про дані. У широкому сенсі це міждисциплінарна область, що поєднує статистику, машинне навчання, алгоритмізацію, аналітику даних та програмування для обробки великих інформаційних масивів (Big Data). Мета Data Science – виявити у великих обсягах даних приховані зв’язки, патерни закономірності, аби перетворити їх на знання. Понад те, ці знання необхідно візуалізувати для простоти сприйняття та використання у практичних завданнях.

Як можуть виглядати рішення Data Science? Наведемо декілька прикладів:

-

Прогнозні моделі, які дають можливість передбачати події, тенденції або ризики. Це системи прогнозування попиту, маркетингові інструменти, платформи фрод-моніторингу, кредитного скорингу тощо.

-

Рекомендаційні системи, які допомагають користувачам знаходити релевантні продукти, послуги або контент: персоналізовані пропозиції в eCommerce, індивідуальні стрічки в соцмережах, алгоритми рекомендації стрімінгу тощо.

-

Системи оптимізації, що дозволяють знаходити найкращі шляхи розв’язання задач. Наприклад, маршрути для логістики, планування виробництва, ціноутворення тощо.

-

Аналітичні інструменти, які візуалізують дані та надають бізнесу чітке уявлення про його діяльність, KPI та можливості для вдосконалення.

Такі рішення сьогодні затребувані як ніколи. Аналітики наразі оцінюють обсяг глобального ринку рішень Data Science щонайменше у $60 млрд, а вже до 2030 року він має всі шанси подолати позначку у $500 млрд.

В чому секрет такого попиту? Сучасні рішення для аналітики даних надають бізнесу вкрай важливі переваги:

-

Підвищення конкурентоспроможності. Data Science дозволяє здобувати цінні знання про ринок, клієнтів та конкурентів, що дає бізнесу змогу будувати ефективну конкурентну стратегію;

-

Збільшення прибутку. Методи Data Science допомагають оптимізувати маркетинг, канали продажів, ціноутворення та інші аспекти бізнесу, що безпосередньо впливають на збільшення доходів;

-

Оптимізація витрат. Data Science може допомогти виявити фактори неефективності та зони зростання, аби оптимізувати операції й знизити видатки.

-

Управління ризиками. Засоби Data Science дозволяють оцінювати та прогнозувати ризики, такі як шахрайство, ризики кредитних дефолтів, проблеми відтоку клієнтів тощо.

-

Покращення ухвалення рішень. Data Science дає змогу приймати рішення на основі даних, а не на основі інтуїції або досвіду, що робить їх більш обґрунтованими та якісними.

Які існують типи Data Science рішень

Аби краще розуміти, що таке розробка data science рішень, варто спочатку визначити їх різновиди. Розгляньмо основні типи таких платформ в деталях.

Аналітичні дашборди та звіти

Наразі дашборди та звіти – це ключові форми візуалізації та презентації даних, що застосовуються у Data Science. Саме поняття дашборду прийшло в інформатику та бізнес-аналітику з автомобільного світу: так називають панель приладів, де водій бачить усі необхідні дані для кермування.

Відтак дашборд для бізнесу демонструє користувачу усі ключові дані для ухвалення рішень та управління операціями. Він має бути інтерактивним та актуальним, в ідеалі оновлюючись у реальному часі. Поняття звітів і дашбордів часто застосовують як синоніми. Але звіти містять статичні та детальні дані, зазвичай вони оформлюються у вигляді таблиць або багатосторінкових аналітичних документів.

Аналітичні дашборди та звіти допомагають людям розуміти дані. Тож етапи розробки data science рішень завжди так чи інакше передбачають роботу над цими інструментами.

Прогностичне моделювання

Це методи Data Science, що використовуються для прогнозування майбутніх подій на основі історичних даних.

Як це працює? Моделі прогнозування будуються на основі історичних даних, аби виявляти приховані закономірності та зв'язки між різними змінними. Ці закономірності надалі використовуються для прогнозування того, що може статися в майбутньому.

В Data Science сформувалось безліч методів, моделей та сценаріїв прогнозування. Назвімо найпоширеніші:

-

Регресійні моделі. Найчастіше застосовуються для прогнозування числових значень, таких як показники фондового ринку, ринкова вартість продукту тощо.

-

Класифікаційні моделі. Використовуються для прогнозування категоричних значень. Наприклад, чи буде клієнт купувати цей продукт?

-

Моделі часових рядів. Застосовуються для прогнозування значень, які змінюються з часом. Це може бути динаміка продажів, прогноз погоди тощо.

Прогнозування за допомогою Data Science сьогодні затребуване у всіх галузях без винятку: від продажів до авіабудування.

Рекомендаційні системи

Це алгоритми обробки даних, що використовуються для цільового підбору продуктів, послуг або контенту, який імовірно сподобається користувачу. Рекомендаційні системи сьогодні застосовуються усюди: в онлайн-магазинах, на відеохостингах, в соцмережах, на стримінгових платформах. Якщо ви дивитесь YouTube або Netflix, то розумієте логіку рекомендацій.

В цьому випадку механізми Data Science використовуються для збору й обробки даних про користувачів: історія пошуку та купівель, переглядів, поведінки на платформі тощо. Ці дані надалі використовуються для навчання алгоритму, який може точно визначати уподобання кожного окремого користувача та формувати релевантну видачу.

Рекомендаційні системи розрізняють за критеріями прогнозування. До основних їх різновидів належать колаборативні, контентні, гібридні моделі тощо. З розвитком машинного навчання та ШІ ці інструменти стають все більш потужними та точними.

Системи фрод-моніторингу

Це алгоритми Data Science, що використовуються для виявлення ознак шахрайських дій. Такі системи використовуються в багатьох галузях, таких як фінанси, охорона здоров'я, страхування, телекомунікації, електронна комерція тощо.

Системи фрод-моніторингу збирають дані про транзакції, події та поведінку користувачів. Цей масив даних використовується для навчання алгоритмів, що можуть ідентифікувати підозрілу активність та шахрайські дії.

Розрізняють два основних різновиди таких платформ:

-

Системи на основі правил, що базуються на заздалегідь визначених інструкціях. Наприклад, алгоритм може фіксувати транзакцію як підозрілу, якщо її сума перевищує певний поріг.

-

Системи машинного навчання, що навчаються на історичних даних і самостійно визначають критерії підозрілої активності. Наприклад, система аналізує історію купівель користувача і бачить нетипові для нього витрати.

Без таких інструментів сьогодні неможливо уявити собі безпеку та управління ризиками у банкінгу, страхуванні, eCommerce тощо.

Cистеми кредитного скорингу

Йдеться про алгоритми оцінки кредитоспроможності позичальників. Подібні рішення незамінні для банків та інших фінансових установ, що прагнуть зібрати сильний кредитний портфель.

Виділяють два основних типи систем кредитного скорингу:

-

Статистичні моделі, що використовують традиційні статистичні методи для прогнозування ймовірності дефолту.

-

Моделі машинного навчання, що використовують алгоритми обробки Big Data для прогнозування ймовірності виплат.

Системи кредитного скорингу на базі Data Science обробляють дані про позичальників, такі як їхня кредитна історія, доходи, зайнятість, заборгованість тощо. Алгоритми навчаються на цих даних та прогнозують ймовірність успішної сплати кредиту.

Чат-боти та віртуальні асистенти

Це програми штучного інтелекту, що можуть розуміти природну усну та письмову мову, а відтак і повноцінно спілкуватися з людиною. Такі інструменти будуються на великих мовних моделях (LLM), що вимагають обробки величезних обсягів даних за методами Data Science.

Сфера застосування чатботів та віртуальних асистентів вкрай широка: типовими прикладами тут є голосовий асистент Google та розумний чатбот ChatGPT. Подібні системи можна пристосувати під будь-які завдання продажів, автоматизації операцій, збору й аналітики даних, користувацької підтримки тощо. Впровадження чатботів і віртуальних асистентів може значно поліпшити взаємодію з клієнтами та прискорити бізнес-процеси.

Це найбільш розповсюджені типи рішень у Data Scinece. Але існує безліч більш специфічних рішень та технологій, створених під унікальні завдання чи потреби бізнесу. Подібні інструменти все частіше розробляються індивідуально. Надалі ми поговоримо про особливості подібної розробки.

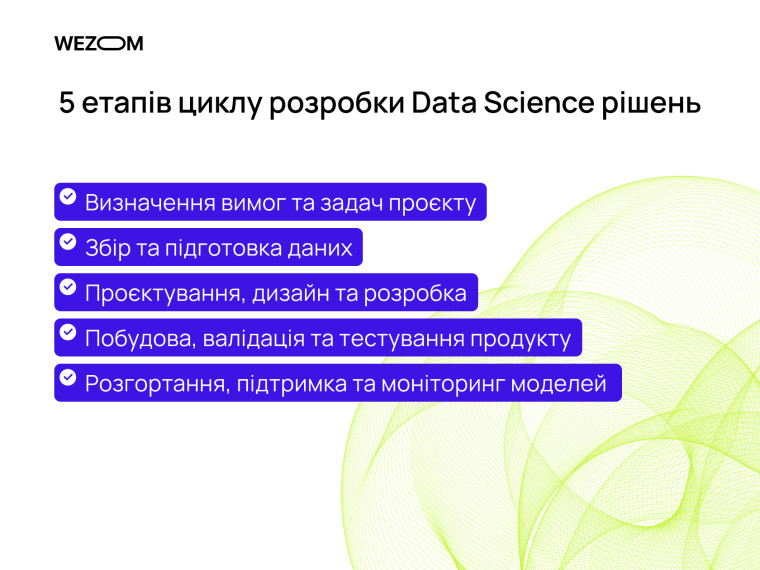

5 етапів циклу розробки Data Science рішень

У бізнеса загалом є два шляхи застосування Data Science: пошук відповідного рішення на ринку ПЗ або ж індивідуальна розробка нового рішення під власні потреби. Ми детально розглянемо другий шлях та розкажемо, як створюються data science рішення. Розберемо усі ключові етапи розробки.

Визначення вимог та задач проєкту

На початку будь-якого проєкту треба відповісти на фундаментальні питання: що треба створити, і навіщо. Команда має визначити основні етапи, функції та параметри нового IT-продукту. Цей процес ведеться у тісному спілкуванні з клієнтом, замовником платформи. За потреби фахівці проводять на цьому етапі бізнес-аналітику: досліджують ринок, цільову аудиторію, рішення конкурентів.

Коли концепція рішення Data Science відома, команда має однозначно та метрично визначити задачу розробки. Наприклад “побудувати модель прогнозування продажів з точністю не менше 80%”. Фахівці визначають джерела необхідних для розв'язання задачі даних, формулюють гіпотези щодо залежностей між змінними, обирають методи аналізу, визначають метрики ефективності тощо.

Збір та підготовка даних

Цей етап має величезне значення для успіху будь-якого проєкту Data Science. Фахівці мають налагодити збір релевантних даних: це можуть бути внутрішні корпоративні data-бази, інформація з відкритих джерел, API, веб-скрапінг тощо. Важливо забезпечити ефективний процес збору даних, щоб не втратити час та ресурси. Варто зважати на їх якість, доступність та вартість збору.

Коли збір даних для навчання моделі налагоджений, їх треба підготувати до роботи. Дані можуть бути структурованими (таблиці, архіви) або неструктурованими (текст, зображення, відео тощо). Увесь цей масив треба уніфікувати, конвертувати у структурований вигляд, очистити від помилок, аномалій, дублювання тощо. За необхідності на основі наявних даних створюються нові показники. Цей процес може охоплювати об’єднання, розрахунок статистичних характеристик, агрегацію тощо. Якісні та чисті дані є основою для точності моделей у Data Science.

Проєктування, дизайн та розробка

Водночас команда ухвалює ключові рішення щодо програмної архітектури нової диджитал-платформи, яка надасть кінцевому користувачу функціонал обробки даних. Розробники визначають стек технологій та високорівневу логіку системи. Тим часом дизайнери визначають UX та створюють перші макети інтерфейсів, дашбордів, форматів подачі звітності у системі тощо.

Усе це дозволяє перейти до звичайного циклу технічної розробки платформи Data Science. Фахівці з фронтенду створюють клієнтську частину платформи, що може мати вигляд мобільного або веб-додатку, адмінпанелі тощо. Бекенд-розробники створюють серверну частину, що буде містити бізнес-логіку продукту. На цьому етапі здійснюється й робота з побудови моделі обробки даних в системі.

Побудова, валідація та тестування продукту

Фахівці обирають методи аналізу даних, такі як ML, статистичний аналіз, інтелектуальні алгоритми тощо. Залежно від потреб проєкту обираються моделі обробки: це може бути лінійна регресія, дерева рішень, нейромережі, кластерний аналіз та ін. При побудові моделі для проєкту важливо обрати у вибірці даних правильні ознаки (фічі), що впливають на результат.

Понад те, команда має переконатись, що запропонована нею модель обробки даних працює. Для цього існує етап валідації та тестування. Валідація передбачає визначення навчальної та тестової вибірки даних. Навчальна вибірка використовується для навчання моделі, а тестова - для оцінювання її здатності до узагальнень. Надалі модель перевіряється на тестовій вибірці даних, які не використовувались в навчанні. Фахівці також мають оцінити низку цільових метрик, таких як точність, F1-міра, AUC-ROC тощо.

Розгортання, підтримка та моніторинг моделей

Якщо якість та працездатність моделі не викликає питань, продукт Data Science розгортається у робочому середовищі для бізнесу, стає доступним кінцевим користувачам. Цей процес зазвичай супроводжується навчанням персоналу, тонким налагодженням дашбордів, усуненням останніх технічних проблем та шліфуванням інтерфейсу системи. В результаті бізнес отримує ефективне та практичне рішення для роботи з даними.

Після релізу важливо забезпечити підтримку та моніторинг продукту, аби гарантувати йому безперебійну роботу та відповідність очікуванням користувачів. Зокрема, моніторити варто KPI та технічну справність. У нашій практиці розробники зазвичай продовжують підтримувати платформу після розгортання: вони за необхідності усувають технічні негаразди, підлаштовують модель під нові вимоги та готують оновлення.

Це базові кроки створення data science рішень, які так чи інакше фігурують в будь-якому проєкті. Однак у кастомній розробці двох однакових продуктів не існує, тож цикл роботи над різними проєктами може суттєво відрізнятися.

Створення Data Science рішення для вашого бізнесу разом з WEZOM

Команда WEZOM вже чверть століття розробляє інноваційні диджитал-рішення для бізнесу у сферах eCommerce, логістики, виробництва, енергетики, девеломпенту, медицини тощо. Ми постійно опановуємо нові технології, проводимо R&D за напрямками ШІ та Big Data, тож добре знаємо, як розробляються рішення науки про дані.

Наша унікальна пропозиція – це створення кастомних IT-продуктів з нуля, що на 100% відповідають специфічним вимогам клієнта щодо функціонала, масштабованості та кібербезпеки. За плечима у WEZOM понад 2 тисячі успішних проєктів, з деякими з них можна ознайомитись у нашому портфоліо на сайті.

Тож якщо вас цікавлять інноваційні рішення на базі ШІ та Big Data – ви опинилися на правильній сторінці. Звертайтеся по консультацію до наших фахівців просто зараз.

Висновки

Сфера Data Science поєднує статистику, машинне навчання, аналітику даних та програмування задля перетворення величезних обсягів інформації на цінні знання для бізнесу. Продукти Data Science – це різноманітні прогнозні моделі, рекомендаційні алгоритми, аналітичні інструменти тощо. Немає такої галузі, в якій можливості обробки даних не принесли дуже відчутної користі.

Як поставити інструменти Data Science на службу бізнесу? У компанії реального сектору загалом є два шляхи: пошук відповідного ПЗ на диджитал-ринку, або ж розробка кастомної системи з нуля. Другий шлях дещо складніший і може видаватися ризикованим, але він надає бізнесу набагато більше переваг: масштабованість, гнучкість, кібербезпека, незалежність від вендорів софту.

Складність полягає в тому, що здійснити таку розробку з нуля без досвіду і знань практично неможливо. Тож найкращим рішенням на цьому напрямку може стати партнерство бізнесу з досвідченою та надійною IT-командою.

FAQ

Навіщо створювати Data Science рішення?

Data Science рішення допомагають виявляти закономірності в даних, прогнозувати події та тренди, вдосконалювати бізнес-процеси та приймати обґрунтовані рішення у будь-якому бізнесі. Вони забезпечують цінні інсайти та підтримують інновації у різних галузях.

Які труднощі можуть виникнути при розробці Data Science рішень?

Процес та цикл розробки рішень науки про дані охоплює безліч складних завдань. Тож проєкт Data Science може зіткнутися з низкою складнощів: нерелевантність/недостатність даних для вибірки, помилковий вибір моделей, оверфіттинг моделей при навчанні тощо. Кожен продукт Data Science залишається унікальним і потребує особливого підходу.

Скільки часу займає розробка Data Science рішень?

Усе залежить від масштабів, складності та специфіки кожного окремого проєкту. Найпростіший MVP продукту з обробки даних можна розгорнути за 5-6 місяців (за умови, що підготовка даних не становитиме проблеми), але розробка повноцінного і комплексного рішення може тривати до року. На щастя, проєкт можна розділити на модулі і розгортати поступово.