В мире облачных сервисов и искусственного интеллекта данные быстро превращаются в самый ценный актив для любого бизнеса. Как распоряжаться этим активом с умом? На помощь приходят решения Data Science, объединяющие статистику, машинное обучение и алгоритмы обработки данных для добычи знаний из огромных объемов информации.

В этом материале мы поговорим о типах и этапах разработки data science решений. Давайте разберемся, как использовать передовые технологии обработки данных для решения практических задач бизнеса.

Что такое Data Science решения ?

Data Science – это не совсем наука о данных. В широком смысле это междисциплинарная область, объединяющая статистику, машинное обучение, алгоритмизацию, аналитику данных и программирование для обработки больших информационных массивов (Big Data). Цель Data Science – обнаружить в больших объемах данных скрытые связи, паттерны и закономерности, чтобы превратить их в знания. Более того, эти знания должны быть визуализированы для простоты восприятия и использования в практических задачах.

Как могут выглядеть решения Data Science? Приведем несколько примеров:

-

Прогностические модели, которые позволяют предвидеть события, тенденции или риски. Это системы прогнозирования спроса, маркетинговые инструменты, платформы фрод-мониторинга, кредитного скоринга и т.д.

-

Рекомендательные системы, которые помогают пользователям находить релевантные продукты, услуги или контент: персонализированные предложения в eCommerce, индивидуальные ленты в соцсетях, алгоритмы рекомендации стриминга и т.д.

-

Системы оптимизации, позволяющие находить наилучшие пути решения задач. Например, маршруты для логистики, планирование производства, ценообразование и т.д.

-

Аналитические инструменты, которые визуализируют данные и предоставляют бизнесу ясное представление о его деятельности, KPI и возможностях развития.

Такие решения сегодня востребованы как никогда. Аналитики сегодня оценивают объем глобального рынка решений Data Science по меньшей мере в $60 млрд, а уже к 2030 году он имеет все шансы преодолеть отметку в $500 млрд.

В чем секрет такого спроса? Современные решения для аналитики данных предоставляют бизнесу очень важные преимущества:

-

Повышение конкурентоспособности. Data Science позволяет получать ценные знания о рынке, клиентах и конкурентах, что позволяет бизнесу строить эффективную конкурентную стратегию;

-

Увеличение прибыли. Методы Data Science помогают оптимизировать маркетинг, каналы продаж, ценообразование и другие аспекты бизнеса, непосредственно влияющие на рост доходов;

-

Оптимизация затрат. Data Science может помочь определить факторы неэффективности и зоны роста, чтобы оптимизировать операции и снизить издержки.

-

Управление рисками. Средства Data Science позволяют оценивать и прогнозировать риски, такие как мошенничество, риски кредитных дефолтов, проблемы оттока клиентов.

-

Улучшение принятия решений. Data Science позволяет принимать решения на основе данных, а не на основе интуиции или опыта, что делает их более обоснованными и качественными.

Какие существуют типы Data Science решений

Чтобы лучше понимать, что такое разработка data science решений, следует сначала определить их разновидности. Рассмотрим основные типы таких платформ в деталях.

Аналитические дашборды и отчеты

На сегодня дашборды и отчеты – это ключевые формы визуализации и презентации данных, применяемых в Data Science. Само понятие дашборда пришло в информатику и бизнес-аналитику из автомобильного мира: так называют приборную панель, где водитель видит все необходимые данные для езды.

Подобным образом дашборд для бизнеса демонстрирует пользователю все ключевые данные для принятия решений и управления операциями. Он должен быть интерактивным и актуальным, в идеале обновляясь в реальном времени. Понятия отчетов и дашбордов часто применяются в качестве синонимов. Но отчеты содержат статические и подробные данные, обычно они оформляются в виде таблиц или многостраничных аналитических документов.

Аналитические дашборды и отчеты помогают людям понимать данные. Так что этапы разработки data science решений всегда так или иначе предполагают работу над этими инструментами.

Прогностическое моделирование

Это методы Data Science, используемые для прогнозирования будущих событий на базе исторических данных.

Как это работает? Модели прогнозирования строятся на основе исторических данных, чтобы выявлять скрытые закономерности и связи между разными переменными. Эти закономерности в дальнейшем используются для прогнозирования того, что может произойти в будущем.

В Data Science сформировалось множество методов, моделей и сценариев прогнозирования. Назовем самые распространенные:

-

Регрессионные модели. Чаще всего используются для прогнозирования числовых значений, таких как показатели фондового рынка, рыночная стоимость продукта и т.д.

-

Классификационные модели. Используются для прогнозирования категоричных значений. К примеру, будет ли клиент покупать этот продукт?

-

Модели временных рядов. Применяются для прогнозирования изменяющихся со временем значений. Это может быть динамика продаж, прогноз погоды и т.д.

Прогнозирование с помощью Data Science сегодня востребовано во всех отраслях без исключения: от продаж до авиастроения.

Рекомендательные системы

Это алгоритмы обработки данных, используемые для целевого подбора продуктов, услуг или контента, которые с большой вероятностью порадуют пользователя. Рекомендательные системы сегодня применяются повсюду: в онлайн-магазинах, видеохостингах, в соцсетях, на стриминговых платформах. Если вы смотрите YouTube или Netflix, то понимаете логику рекомендаций.

В этом случае механизмы Data Science используются для сбора и обработки данных о пользователях: истории поиска и покупок, просмотров, поведения на платформе и т.д. Эти данные используются для обучения алгоритма, который может точно определять предпочтения каждого отдельного пользователя и формировать релевантную выдачу.

Рекомендательные системы различают по критериям прогнозирования. К основным их разновидностям относятся коллаборативные, контентные, гибридные модели и т.д. С развитием машинного обучения и ИИ эти инструменты становятся все более мощными и точными.

Системы фрод-мониторинга

Это алгоритмы Data Science, используемые для выявления признаков мошеннических действий. Такие системы используются во многих областях, таких как финансы, здравоохранение, страхование, телекоммуникации, электронная коммерция и т.д.

Системы фрод-мониторинга собирают данные о транзакциях, событиях и поведении пользователей. Этот массив данных используется для обучения алгоритмов, которые могут идентифицировать подозрительную активность и мошеннические действия.

Различают две основные разновидности таких платформ:

-

Системы на основе правил, которые базируются на заранее определенных инструкциях. Например, алгоритм может фиксировать транзакцию как подозрительную, если сумма превышает определенный порог.

-

Системы машинного обучения, которые строятся на исторических данных и самостоятельно определяют критерии подозрительной активности К примеру, система анализирует историю покупок пользователя и видит нетипичные для него затраты.

Без таких инструментов сегодня невозможно представить себе безопасность и управление рисками в банкинге, страховании, eCommerce и т.д.

Системы кредитного скоринга

Речь идет об алгоритмах оценки кредитоспособности заемщиков. Подобные решения незаменимы для банков и других финансовых учреждений, стремящихся собрать сильный кредитный портфель.

Выделяют два основных типа систем кредитного скоринга:

-

Статистические модели, которые используют традиционные статистические методы для прогнозирования вероятности дефолта.

-

Модели машинного обучения, использующие алгоритмы обработки Big Data для прогнозирования вероятности выплат.

Системы кредитного скоринга на базе Data Science обрабатывают данные о заемщиках, такие как их кредитная история, доходы, занятость, задолженность и т.д. Алгоритмы учатся на данных и прогнозируют вероятность успешной оплаты кредита.

Чат-боты и виртуальные ассистенты

Это программы искусственного интеллекта, которые могут понимать естественный устный и письменный язык, а значит и полноценно общаться с человеком. Такие инструменты строятся на больших языковых моделях (LLM), требующих обработки больших обьемов данных по принципам Data Science.

Сфера применения чатботов и виртуальных ассистентов крайне широка: типичными примерами здесь могут быть голосовой ассистент Google и умный чатбот ChatGPT. Такие системы можно приспособить под любые задачи продаж, автоматизации операций и аналитики данных, пользовательской поддержки и т.п. Внедрение чатботов и виртуальных ассистентов может существенно улучшить взаимодействие с клиентами и ускорить бизнес-процессы.

Это наиболее распространенные типы решений Data Scinece. Но существует множество более специфических решений и технологий, созданных под уникальные задачи или потребности бизнеса. Подобные инструменты все чаще разрабатываются индивидуально. В дальнейшем мы поговорим об особенностях подобной разработки.

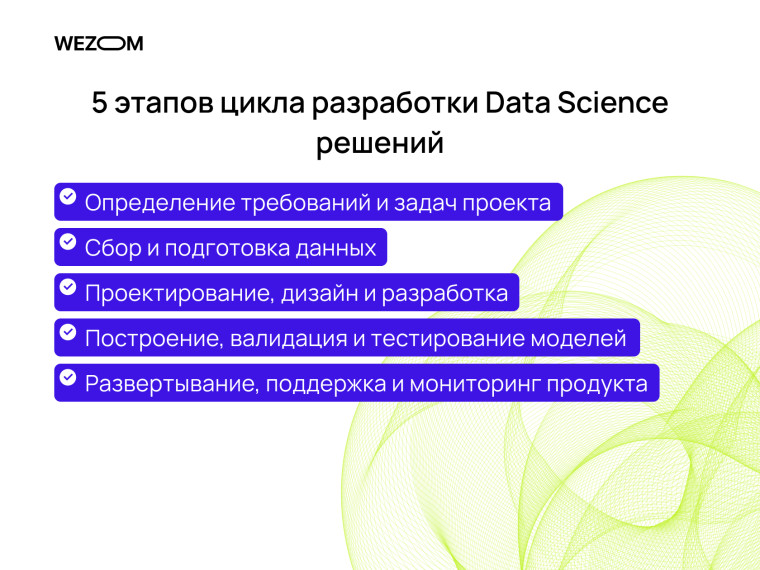

5 этапов цикла разработки Data Science решений

У бизнеса в целом есть два пути применения Data Science: поиск соответствующего решения на рынке ПО, или индивидуальная разработка нового решения под собственные нужды. Мы подробно рассмотрим второй путь и расскажем, как создаются data science решения. Разберем все ключевые этапы разработки.

Определение требований и задач проекта

В начале любого проекта нужно ответить на фундаментальные вопросы: что нужно создать, и зачем. Команда должна определить основные этапы, функции и параметры нового IT-продукта. Этот процесс ведется в тесном общении с клиентом, заказчиком платформы. При необходимости специалисты проводят на этом этапе бизнес-аналитику: исследуют рынок, целевую аудиторию, решения конкурентов.

Когда концепция решения Data Science известна, команда должна однозначно и метрически определить задачу разработки. Например "построить модель прогнозирования продаж с точностью не менее 80%". Специалисты определяют источники необходимых для решения задачи данных, формулируют гипотезы относительно зависимостей между переменными, выбирают методы анализа, определяют метрики эффективности и т.п.

Сбор и подготовка данных

Этот этап имеет огромное значение для успеха любого проекта Data Science. Специалисты должны наладить сбор релевантных данных: это могут быть внутренние корпоративные data-базы, информация из открытых источников, API, веб-скрапинг и т.д. Важно обеспечить эффективный процесс сбора данных, чтобы не потерять время и ресурсы. Следует учитывать их качество, доступность и стоимость сбора.

Когда сбор данных для обучения модели налажен, их надо подготовить к работе. Данные могут быть структурированными (таблицы, архивы) или неструктурированными (текст, изображения, видео). Так что весь этот массив нужно унифицировать, конвертировать в структурированный вид, очистить от ошибок, аномалий, дублирования и т.д. При необходимости на основе имеющихся данных создаются новые показатели. Этот процесс может включать объединение, расчет статистических характеристик, агрегацию и т.д. Качественные и чистые данные являются основой для точности моделей Data Science.

Проектирование, дизайн и разработка

Тем временем команда принимает ключевые решения по программной архитектуре новой диджитал-платформы, которая предоставит конечному пользователю функционал обработки данных. Разработчики определяют стек технологий и высокоуровневую логику системы. В то же время дизайнеры определяют UX и создают первые макеты интерфейсов, дашбордов, форматов подачи отчетности в системе и т.д.

Все это позволяет перейти к обычному циклу технической разработки платформы Data Science. Специалисты по фронтенду создают клиентскую часть платформы, которая может быть выполнена в виде мобильного или веб-приложения, админпанели и т.д. Бэкэнд-разработчики создают серверную часть, которая будет содержать бизнес-логику продукта. На этом этапе осуществляется и работа по построению модели обработки данных в системе.

Построение, валидация и тестирование моделей

Специалисты выбирают методы анализа данных, такие как ML, статистический анализ, интеллектуальные алгоритмы и т.д. В зависимости от потребностей проекта выбираются модели обработки: это может быть линейная регрессия, древа решений, нейросети, кластерный анализ и т.д. При построении модели для проекта важно определить в выборке данных правильные признаки (фичи), влияющие на результат.

Более того, команда должна убедиться, что предложенная модель обработки данных работает. Для этого существует этап валидации и тестирования. Валидация предполагает определение обучающей и тестовой выборки данных. Обучающая выборка используется для обучения модели, а тестовая – для оценки ее способности к обобщениям. В дальнейшем модель проверяется на тестовой выборке данных, не используемых в обучении. Специалисты должны оценить ряд целевых метрик, таких как точность, F1-мера, AUC-ROC и т.д.

Развертывание, поддержка и мониторинг продукта

Если качество и работоспособность модели не вызывает вопросов, продукт Data Science развертывается в рабочей среде для бизнеса, становится доступным конечным пользователям. Этот процесс обычно сопровождается обучением персонала, тонкой настройкой дашбордов, устранением последних технических проблем и шлифованием интерфейса системы. В результате бизнес получает эффективное и практичное решение для работы с данными.

После релиза важно обеспечить поддержку и мониторинг продукта, чтобы гарантировать ему бесперебойную работу и соответствие ожиданиям пользователей. В частности, мониторить следует KPI и техническую исправность платформы. В нашей практике разработчики зачастую продолжают поддерживать платформу после развертывания: они при необходимости устраняют технические проблемы, подстраивают модель под новые требования и готовят обновления.

Это базовые шаги создания data science решений, так или иначе фигурирующие в любом проекте. Однако в кастомной разработке двух одинаковых продуктов не существует, так что цикл работы над разными проектами может существенно отличаться.

Создание Data Science решения для вашего бизнеса вместе с WEZOM

Команда WEZOM уже четверть века разрабатывает инновационные диджитал-решения для бизнеса в сферах eCommerce, логистики, производства, энергетики, девеломпента, медицины и т.д. Мы постоянно осваиваем новые технологии, проводим R&D по направлениям ИИ и Big Data, поэтому хорошо знаем, как разрабатываются решения науки о данных.

Наше уникальное предложение – это создание кастомных IT-продуктов с нуля, которые на 100% отвечают специфическим требованиям клиента в части функционала, масштабируемости и кибербезопасности. За плечами у WEZOM более 2 тысяч успешных проектов, с некоторыми из них можно ознакомиться в нашем портфолио на сайте.

Если вас интересуют инновационные решения на базе ИИ и Big Data – вы оказались на правильной странице. Обращайтесь за консультацией к нашим специалистам прямо сейчас.

Выводы

Сфера Data Science объединяет статистику, машинное обучение, аналитику данных и программирование для превращения огромных объемов информации в ценные знания для бизнеса. Продукты Data Science – это разнообразные прогностические модели, рекомендательные алгоритмы, аналитические инструменты и т.д. Нет такой отрасли, в которой возможности обработки данных не принесли очень ощутимой пользы.

Как поставить инструменты Data Science на службу бизнесу? У компании реального сектора в целом есть два пути: поиск соответствующего ПО на диджитал-рынке, или разработка кастомной системы с нуля. Второй путь несколько сложнее и может казаться рискованным, но он предоставляет бизнесу гораздо больше преимуществ: масштабируемость, гибкость, кибербезопасность, независимость от вендоров софта.

Сложность заключается в том, что осуществить такую разработку с нуля без опыта и знаний практически невозможно. Наилучшим решением на этом направлении может стать партнерство бизнеса с опытной и надежной IT-командой.

FAQ

Зачем создавать Data Science решения?

Решения Data Science помогают выявлять закономерности данных, прогнозировать события и тренды, совершенствовать бизнес-процессы и принимать обоснованные решения в любом бизнесе. Они обеспечивают ценные инсайты и поддерживают инновации в разных сферах.

Какие трудности могут возникнуть при разработке Data Science решений?

Процесс и цикл разработки решений науки о данных охватывает множество сложных задач. Проект Data Science может столкнуться с рядом сложностей: нерелевантность/недостаточность данных для выборки, ошибочный выбор моделей, оверфиттинг моделей при обучении и т.д. Каждый продукт Data Science остается уникальным и нуждается в особом подходе.

Сколько времени занимает разработка Data Science решений?

Все зависит от масштабов, сложности и специфики каждого отдельного проекта. Простейший MVP продукта по обработке данных можно реализовать за 5-6 месяцев (при условии, что подготовка данных не составит проблемы), но разработка полноценного и комплексного решения может занять до года. К счастью, проект можно разделить на модули и развертывать постепенно.