Робота в кожній сфері діяльності регулюється різними правилами і, відповідно, санкціями, якщо хтось їх не дотримується. Наприклад, якщо професійний спортсмен порушує правила гри, його карають за це. Залежно від того, наскільки серйозним є відхилення від загальноприйнятих норм, його можуть тимчасово видалити з гри або усунути від участі у змаганнях на певний період.

Фільтри Google дуже схожі на спортивні штрафи. У цій статті ми розберемося разом, чому сайт може потрапити під санкції і що потрібно зробити, щоб уникнути цього.

Фільтри Google — що це таке?

За своєю суттю фільтри Гугл розроблені для покарання сайтів, на яких міститься непотрібний контент або у просуванні використовувалися «чорні» методи. У такий спосіб пошукова система бореться з неякісними ресурсами та прагне зробити результати пошукової видачі максимально корисними. Тобто якщо оцінити роботу таких алгоритмів Google з погляду споживача, то вони потрібні.

З іншого боку, для власника сайту потрапляння під фільтри може означати справжній крах, оскільки на створення та просування сайту було витрачено безліч ресурсів. Фактично через неправильні дії непрофесійних сеошників можуть бути марно втрачені час та гроші.

Кожному власнику онлайн-бізнесу буде корисно знати, що фільтри Гугл, які використовуються пошуковими системами для перевірки та ранжування вебсайтів, поступово ускладнюються та стають суворішими.

У зв'язку з цим як для власників сайтів, так і для співробітників, відповідальних за SEO-просування, дуже важливо розібратися в різних видах санкцій, зрозуміти, з яких причин вони можуть бути задіяні і як їх уникнути.

Як визначити, що сайт потрапив під фільтр від Google

Зараз діагностика сайту та розпізнавання дії фільтрів стають складнішими порівняно з тим, що було раніше. Минули часи, коли санкції накладалися на певний період, і з різкого падіння трафіку можна було зрозуміти, що ресурс потрапив під дію штрафів. У даний час фільтри Google інтегровані в пошукові алгоритми і не дають низькоякісним сайтам зростати за багатьма показниками. Тобто сайт більше не стикається із різкою втратою трафіку, але й не може досягти гарного зростання. Різке зниження трафіку через фільтри спостерігається тільки при впровадженні абсолютно нових апдейтів, які потім стають невід'ємною частиною алгоритму і діють, як би встановлюючи «скляну стелю» в прогресі сайту. Давайте разом розбиратися, як перевірити сайт на фільтри Google.

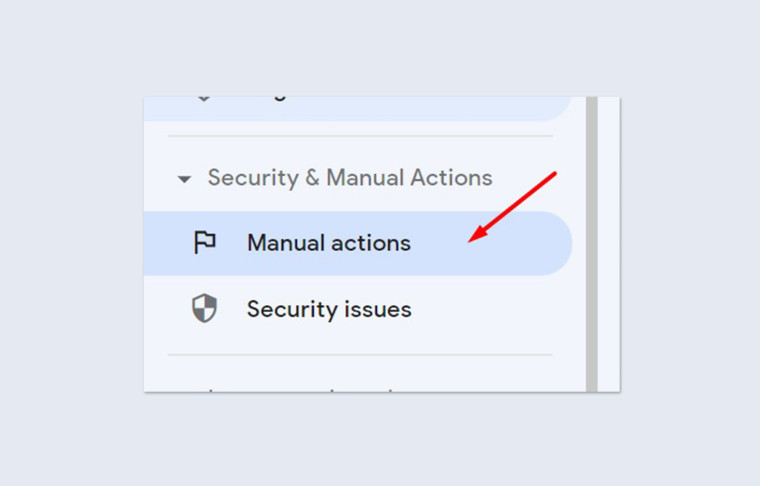

1. Перевіряємо обмеження, накладені вручну

Почати слід з перевірки, чи не потрапив сайт під так звані ручні санкції. Це своєрідний результат рішення співробітників Google після перевірки сайту вручну. Цим займатимуться в компанії, якщо на вебресурс хтось поскаржиться або буде отримано сигнал від алгоритмів про множинні порушення. Наприклад, може бути виявлена небажана активність посилань, порушення авторських прав, публікація низькоякісного контенту або інші дії, які вважаються неприпустимими з точки зору Google.

Якщо ваш сайт потрапив під будь-які обмеження, накладені вручну, ви зможете їх виявити, перейшовши до розділу Google Search Console під назвою «Manual Actions».

2. Аналізуємо пошуковий трафік

Google Analytics представляє чудову можливість для відстеження та розуміння змін у трафіку на сайт. У цьому сервісі можна побачити періоди, коли починається зниження відвідуваності. Якщо ви помітили проблеми, обов'язково здійсніть аналіз даних за кілька місяців. Так ви зможете зафіксувати час появи проблеми, щоб пошукати її причину.

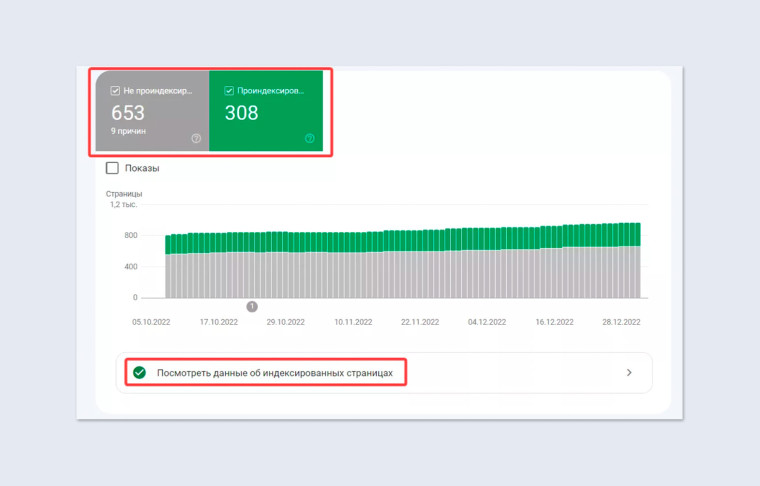

3. Перевіряємо кількість сторінок в індексі та динаміку цього показника

Спочатку варто встановити, чи не потрапив сайт повністю під штрафні санкції. Для цього потрібно ввести у пошуковому рядку Google «site:ваш домен» і подивитися на результат. Якщо результати пошуку не з'являться, це може означати, що вебресурс виключено з пошукової видачі.

Якщо сайт вже був проіндексований раніше і тепер зник з результатів пошуку Google, це може бути пов'язано лише із загальним штрафом на рівні всього онлайн-проєкту або його додаванням до чорного списку. Якщо сайт новий, пам'ятайте, що індексація може зайняти від декількох днів до тижня, тому немає необхідності панікувати, якщо він ще не відображається у пошуку.

За такого способу перевірки варто звернути увагу на кількість сторінок в індексі. Якщо ви спостерігаєте зменшення їх кількості, то потрібно перевірити ще раз кількість проіндексованих сторінок у Google Search Console. Там можна побачити тимчасову шкалу та зрозуміти, чому ті чи інші сторінки не індексуються.

4. Перевіряємо позиції сайту за допомогою сервісів

Існують різні інструменти онлайн для відстеження індексації сайту. Як приклад можна назвати linkody.com чи smallseotools.com. Але вони мають обмеження у безкоштовних версіях.

Точніші дані про позиції сайту дасть Google Search Console. Також буде корисним інструмент від Serpstat.

Що робити, якщо позиції впали і сторінки не проіндексовані

Отже, припустимо, що ви з'ясували, що позиції вашого сайту погіршилися і окремі сторінки не індексуються (зазвичай викликає тривогу індексація ключових посадкових сторінок). У такому разі необхідно перевірити статус та тип сторінок, виключених з індексу. Отримати таку інформацію можна у Google Search Console. А далі — постаратися зрозуміти, під дію якого саме фільтра потрапив ваш сайт, і працювати вже точково.

Базові офіційні фільтри Google: діагностика та лікування

Хоч би що говорили, а корпорація Google — це справжній лідер у боротьбі з несумлінними методами просування сайтів. Фільтри пошукової системи Google регулярно оновлюються. В результаті користувач отримує якісніші відповіді на свої запити, а фахівці постійно моніторять позиції вебресурсів і вирішують головоломки, чому позиції змінилися.

Пропонуємо розглянути, як працюють фільтри Гугл, які застосовуються найчастіше.

1. Panda (Панда): принцип роботи та лікування

Алгоритм під цією назвою включений у роботу з 2011 року. Його основне завдання — боротьба з неякісним або дубльованим контентом на сайтах та виключення нерелевантних сторінок із пошуку.

Сайт потрапляє під цей фільтр найчастіше за таких умов:

- контент на сторінках вебресурсу не відповідатиме параметрам — оригінальності, інформативності, корисності та унікальності;

- на сайті у різних розділах будуть однакові чи схожі матеріали. Мається на увазі дубльований контент всередині самого вебресурсу або скопійований з інших джерел;

- на сторінках недостатня кількість вмісту. Це особливо актуально для інтернет-магазинів, де картки товарів з неповними або малоінформативними описами можуть бути повністю виключені з індексу;

- відвідувачі проводять мало часу на сайті та швидко повертаються знову до пошукової видачі. Це свого роду сигнал для пошуковика про те, що якість контенту не відповідає очікуванням.

Ми рекомендуємо регулярно стежити за оновленнями цього та інших алгоритмів, тому що вимоги щодо якості контенту можуть змінюватися з часом.

Пропонуємо вам кілька порад щодо того, як визначити, що сайт під фільтром Google, і що треба зробити, щоб цього не сталося.

|

Проблеми |

Як перевірити |

Як не допустити |

|

На сторінках немає корисного контенту |

Перевірити список сторінок, виключених з індексу. Розмістити на них якісні тексти |

Розміщувати інформативні тексти на нові сторінки ДО того, як вони будуть проіндексовані, або позначити їх як «noindex» |

|

Невідповідність єдиній темі |

Переглянути вміст сайту та видалити сторінки з текстами на інші теми

|

Чітко розробляти структуру та вміст сайту на основі єдиної тематичної стратегії |

|

Низькі показники користувача |

За допомогою Google Search Console знайти сторінки, які мають найбільший показник відмов, та опрацювати |

Тестувати роботу всіх форм, кнопок швидкого замовлення до індексації

|

Також радимо:

- позбавитися дубльованих сторінок, усунути скопійовані тексти, оптимізувати внутрішню структуру посилань;

- урізноманітнити текстовий контент на сайті за допомогою маркованих та нумерованих списків, зображень, графіків та відео. Крім того, актуалізуйте тексти — регулярно доповнюйте їх свіжою інформацією;

- перевірити, чи відповідають заголовки на сайті змісту сторінок;

- усунути зайві повторення ключових слів у тексті, заголовках від h1 до h6, метатеги та описи зображень.

Є ще ціла низка алгоритмів, які з'явилися раніше, але потім вони стали частиною фільтра Panda.

Додаткові результати (Supplemental results)

Суть цього фільтра в тому, що якщо на сайті буде багато текстів, які не несуть оригінальної інформації, а будуть рерайтами з інших джерел, пошукова система вважатиме такий онлайн-проєкт недостатньо якісним. Такий вебресурс не буде виключений з індексу повністю, але він відображатиметься у розділі з додатковими результатами, а тому трафік на сторінку просяде. Серед останніх анонсів Google є інформація про те, що для визначення схожих за змістом текстів застосовуватимуться інструменти на основі ШІ.

Надмірна оптимізація (Over Optimization)

Як і інші фільтри пошукової системи Google, цей був розроблений для боротьби з сайтами, які були заспамлені ключовими словами та фразами. Але цей штраф запуститься, якщо на вебсторінці, у її HTML-тегах та метатегах виявиться надмірна кількість ключових слів та фраз. Це призведе до погіршення позицій сторінки у результатах пошуку.

Дубльований контент (Duplicate content)

За ключі, які повторюються на різних сторінках, сайт також може бути притягнутий до санкцій з боку алгоритму Google Panda. Тому важливо не створювати нову сторінку кожного запиту, а правильно групувати семантику і, відповідно, тексти.

2. Пінгвін (Penguin): принцип дії та лікування

Цей фільтр Гугл був розроблений для того, щоб боротися з маніпуляціями у сфері посилань. Алгоритм оцінює якість та природність посилань, що вказують на сайт. На відміну від Google Panda, який може негативно вплинути на ранжування сайту, Penguin застосовується до окремих сторінок.

Пропонуємо вам список типових порушень, за які може бути використаний цей фільтр:

- участь у схемах обміну посиланнями, пірамідах та інших маніпуляціях;

- застосування на сайті прихованих посилань;

- надто часте використання ключів в анкорах;

- наявність низькоякісних чи спамних посилань;

- використання автоматичних програм або ботів для створення та розповсюдження посилань;

- участь у «чорних» SEO-практиках.

Пам'ятайте, що будь-які маніпуляції з посиланнями чи контентом, які суперечать вимогам щодо якості та доброчесності, можуть викликати санкції.

А тепер кілька корисних порад від наших спеціалістів:

|

Проблеми |

Як перевірити |

Як не допустити |

|

Стрімке зростання числа зовнішніх посилань |

Вивантажити список донорів та перевірити його за допомогою онлайн-сервісів, наприклад, Majestic |

Розробити оптимальну стратегію посилального просування з органічним нарощуванням посилальної маси |

|

Розміщення посилань на неякісних ресурсах |

Застосувати інструмент відключення посилань Disavow та направити запит на зняття санкцій |

Виконувати ретельну перевірку донорів перед покупкою та розміщенням посилань |

До різновидів алгоритму Penguin належать такі:

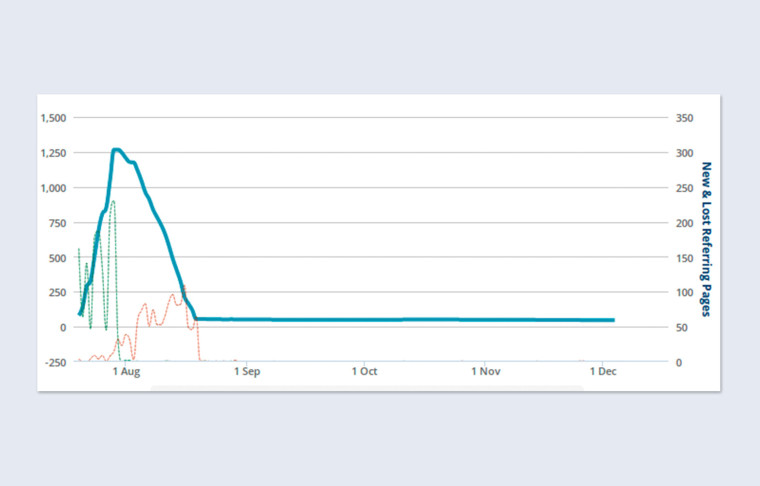

1. Різке зростання маси посилань (Too many links at once)

Фільтр «Пінгвін» також включає фактор, що враховує рівномірність зростання посилань. Якщо відбудеться різкий стрибок кількості доменів, що посилаються, то до самого вебресурсу потенційно можуть бути застосовані санкції. Тому бажано поступово нарощувати посилальну масу, щоб уникнути можливих штрафів.

2. Спільне цитування (Co-citation linking filter)

Цей фільтр активується, якщо на сторінки сайту посилаються нетематичні ресурси. Зазвичай це відбувається, коли вибір донорів здійснюється неправильно, не враховуючи їх тематики. Сайт також може бути оштрафований, якщо він розміщує посилання на спам-сайтах, які мають низький рівень довіри та посилаються на різні не пов'язані ресурси.

Щоб не потрапити під цей фільтр, важливо купувати посилання лише на сайтах у схожій ніші чи сфері. При цьому щомісячний приріст таких посилань не повинен перевищувати 20% поточної кількості посилань.

Коротко про додаткові фільтри Google

А тепер згадаємо про інші алгоритми пошукової системи, враховувати які обов'язково у своїй роботі. Додаткові фільтри Google також допомагають стежити за якістю ресурсу.

Що таке Baby Panda

Цей алгоритм побачив світ у 2012 році. Його основна функція — контроль кількості реклами на головній сторінці вебресурсу. Цей фільтр був представлений після офіційного випуску Panda і отримав приставку Baby через свою схожість із першим. Він націлений на інтернет-ресурси, де головні сторінки перевантажені рекламними банерами. Внаслідок роботи цього алгоритму пошукова система почала знижувати рейтинг таких сайтів у результатах пошуку. Щоб запобігти цьому, намагайтеся зменшити кількість рекламних банерів на сайті.

Принцип дії Exact Match Domain (EMD)

Раніше вважалося, що включення ключа в назву домену може сприяти покращенню рейтингу пошукової видачі. З початку 2012 року ця методика припинила діяти і, навпаки, це призводить до погіршення ранжування. Якщо цей фільтр був активований одразу після створення сайту, то проєкту буде складно досягти високих позицій у пошуковій видачі. Однак якщо домен із ключовою фразою вже існує, його рейтинг може впасти, але повністю зникнути з видачі він не повинен, оскільки в оцінці ранжування враховуються інші фактори.

Якщо ваш сайт потрапив під дію цього фільтра, то, можливо, доведеться змінити доменне ім'я і запустити переадресацію (301 редирект). Для профілактики рекомендовано ретельно вибирати назву вебресурсу.

Чи можна обійти DMCA (Pirate)

За своїм способом дії цей фільтр також нагадує Panda, але його дії регулюються законами про авторське право та спрямовані на захист від копіювання інформації з інших інтернет-ресурсів. У разі надходження скарг на порушення авторських прав власнику сайту доведеться видалити неоригінальний контент та замінити його на унікальний. Як варіант усунення проблеми може бути розміщення посилання на першоджерело. Але це не завжди спрацьовує. Отже, головна рекомендація — не користуватися чужими напрацюваннями.

Чому поганий спам у мікророзмітці

Коректна розробка сніпетів істотно підвищує ймовірність переходу користувачів, наявність оцінок та рейтингових зірочок викликає більше довіри до вебресурсу. Однак деякі фахівці зловживають цією практикою, додаючи рейтинги та оцінки до мікророзмітки на сторінках, де це не передбачено за стандартом. Якщо це виявиться, то сторінку буде знижено у видачі. Нагадаємо, перевірити мікророзмітку можна у Google Search Console.

Що таке Смітник (Links)

Цей фільтр покликаний боротися з поняттям, відомим як «посилальна помийка». Під цим терміном маються на увазі сайти, які містять надмірну кількість вихідних посилань на одній сторінці. Перевірити їх кількість та тематичну відповідність можна за допомогою онлайн-сервісу Screaming Frog SEO Spider. При виявленні проблеми необхідно буде почистити список зовнішніх посилань.

Як усунути Биті посилання (Broken links)

Після того, як на ресурсі-донорі видаляють посилання, на вихідному сайті з'являються биті посилання. Також вони виникають у результаті видалення сторінок, зміни назв розділів чи підрозділів. Коли це відбувається, існуючі внутрішні посилання можуть вести до сторінок, яких не існує. Відповідно, при переході на них вони відображаються як сторінки з помилкою 404. Якщо таких сторінок занадто багато, загальна оцінка якості сайту знижується, і його позиції у пошуковій видачі погіршуються.

Знайти та вивантажити список таких сторінок допоможуть численні онлайн-інструменти (наприклад, Screaming Frog). Далі їх можна видалити або закрити від індексації.

Щоб така проблема не виникала, необхідно при зміні адреси сторінки налаштовувати 301 редирект. Також важливим є регулярний моніторинг та видалення посилань на неіснуючі сторінки.

Секрети неофіційних фільтрів

До цієї категорії належать фільтри Гугл, Про які немає згадки в офіційних джерелах Google, але їхню дію знають SEO-фахівці з різних точок світу.

Що таке -5, -30, -950

Йдеться про погіршення рейтингу у пошуковій видачі через застосування методів «чорного SEO». Спостерігається зниження позицій на 5, 30 і навіть 950 позицій. Цей фільтр застосовується у разі таких порушень:

- клоакінг — розміщення різного контенту для користувачів та для пошукових роботів;

- дорвеї — сайти, які генерують трафік і перенаправляють відвідувачів на інші вебресурси;

- використання прихованих редиректів, які також перенаправляють користувачів на сторінки, сховані від індексації.

Якщо не усунути ці порушення, спочатку сайт втратить свої позиції, а потім може бути повністю виключений з пошукового індексу.

Алгоритм дій, якщо сайт потрапив під штраф від Google

Якщо ваш сайт потрапив під фільтр Google і його позиції у пошуковій видачі значно погіршилися, то ми рекомендуємо діяти таким чином:

- уважно вивчіть повідомлення Google Search Console, виконайте аудит за допомогою інших сервісів, про які ми згадували у цій статті, та визначте, який фільтр міг вплинути на позиції сайту. Розуміння природи проблеми допоможе правильно розв'язати її;

- якщо ви виявили, в чому причина порушень, наприклад, вона може бути пов'язана з контентом або посиланнями, негайно почніть роботу над їх усуненням;

- якщо фільтр пов'язаний з порушеннями авторських прав, переконайтеся, що на вашому вебресурсі немає контенту, на розміщення якого ви не маєте права;

- ще раз перечитайте рекомендації Google щодо SEO. Переконайтеся, що ваш сайт відповідає стандартам та рекомендаціям пошукової системи;

- після того, як ви переконаєтеся, що основні проблеми усунуті і сайт більше не порушує правила Google, ви можете подати запит на перегляд через Google Search Console. У заявці поясніть, які зміни були зроблені і чому ваш сайт більше не повинен бути підданий фільтру;

- після подання запиту на перегляд доведеться зачекати деякий час. А поки продовжуйте стежити за тим, як сайт індексується та як змінюються його позиції у пошуковій видачі.

І нарешті, не намагайтеся усунути проблему лише для того, щоб уникнути фільтра. Працюйте над постійним покращенням якості сайту, щоб довгостроково підтримувати високі позиції у пошуковій видачі.