Сфера контролю якості софту постійно розвивається. Швидкість розробки зростає, складність систем збільшується. Відтак зростає і потреба в ефективних та надійних інструментах для автотестів. Ще кілька років тому автоматизація тестування програмного забезпечення концентрувалась навколо класичних фреймворків QA, але сьогодні ми спостерігаємо кардинальний зсув у підходах. Тепер у центрі уваги – інструменти на базі ШІ, великі мовні моделі (LLM), генерація тестів на основі опису вимог, глибока інтеграція з CI/CD-процесами тощо. Перевірені роками технології стрімко втрачають актуальність, але вивчення нових рішень потребує часу та ресурсів.

Тож як ефективно автоматизувати процеси QA у реаліях 2025 року? У цій статті ми розберемо найактуальніші інструменти та рішення, що дозволяють вивести тестування на новий рівень. Розгляньмо ключові тренди, порівняємо популярні IDE, оцінимо можливості генераторів API-тестів та дослідимо потенціал великих мовних моделей. Цей невеликий огляд буде корисним як для тестувальників-початківців, так і для досвідчених QA-інженерів.

Головні тренди автоматизації

Сьогодні автоматизація QA вийшла далеко за межі традиційного автотестування. Тепер це – про розумні системи, що інтегруються у життєвий цикл розробки, і здатні самостійно генерувати, адаптувати та виконувати тести, формувати та доповнювати документацію, аналізувати баги та вимоги тощо. Розгляньмо технології, що заклали основу для цих нових рішень.

Штучний інтелект та LLM

Просто зараз інтеграція ШІ в QA-процеси повністю змінює підходи до контролю якості. Такі засоби як великі мовні моделі (LLM – Large Language Models) можуть взяти на себе купу рутинних завдань:

-

Аналіз документації та автоматизоване створення тест-кейсів;

-

Генерація коду автотестів за простим текстовим описом;

-

Проведення рев’ю тестів або автопошук слабких місць у покритті;

-

Визначення найбільш критичних сценаріїв для перевірки.

Інструменти на базі GPT-подібних моделей вже стали частиною повсякденної роботи QA-команд — як у вигляді вбудованих помічників у IDE, так і через зовнішні сервіси.

Генерація тестів на основі опису вимог

Сьогодні замість ручного написання десятків сценаріїв, QA-фахівець може надати спеціалізованому інструменту вимоги у вільній формі або у вигляді user story, а у відповідь отримати:

-

Набір функціональних автотестів.

-

Тестові приклади для edge-case ситуацій.

-

UI-макети з готовими перевірками

Цей підхід значно пришвидшує старт тестування, особливо у fast-paced Agile-командах.

Тісна інтеграція QA у CI/CD-пайплайни

Напрямок QA більше не ізольований — він стає частиною DevOps-культури. У сучасних процесах CI/CD (Continuous Integration / Continuous Delivery) новітні інструменти дають низку можливостей:

-

Тести запускаються при кожному коміті, пул-реквесті або деплої.

-

Результати тестування впливають на рішення про вивід нової версії у продакшн.

-

Для ізольованого тестування застосовуються динамічні середовища.

Це не лише забезпечує швидкий фідбек щодо якості, але й створює культуру відповідальності за стабільність продукту на всіх етапах.

Low-code/no-code автоматизація

Водночас зростає попит на інструменти, які дозволяють створювати автотести без глибокого знання мов програмування. Такі платформи:

-

Дають можливість швидко будувати тести через drag-and-drop інтерфейси.

-

Доступні для мануальних тестувальників, бізнес-аналітиків та інших non-tech учасників процесу.

-

Чудово інтегруються з традиційними фреймворками через API або конектори.

Переваги подібних рішень особливо добре проявляють себе у невеликих проєктах, при створенні MVP, прототипів тощо.

Фокус на тестах API та контрактному тестуванні

У 2025 році все більше QA-команд концентруються на тестуванні API як основи перевірки логіки додатків. На це є декілька причин:

-

API-тести швидші, стабільніші та дешевші в підтримці, ніж UI-тести.

-

Контрактне тестування допомагає виявити несумісності між мікросервісами до релізу.

-

Чимало інструментів (наприклад, Postman, Pact, RestAssured) тепер підтримують автоматичну генерацію та валідацію контрактів.

Наведені тренди не лише змінюють інструменти, якими ми користуємось – вони трансформують саму роль QA у проєкті, залучають контроль якості до всіх етапів розробки.

Генерація автотестів з ШІ: інструменти, що змінюють QA

LLM-моделі та спеціалізовані ШІ-сервіси відкрили можливість створювати тести практично “з повітря” — з документації, user story або специфікацій OpenAPI. Давайте розглянемо подібні рішення, доступні тестувальникам просто зараз.

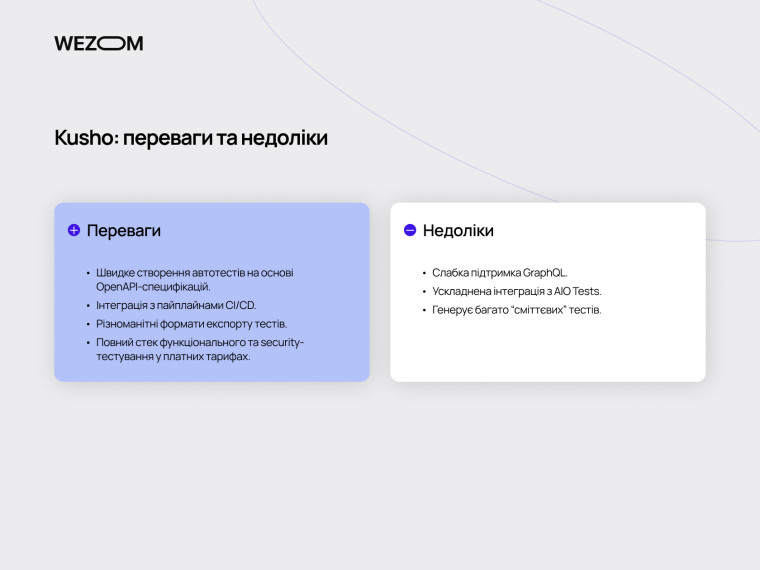

Kusho: генерація API-тестів

Популярна AI-платформа Kusho – дуже затребуване рішення для автоматизованого тестування. Вона спеціалізується на генерації API-тестів із використанням OpenAPI/Swagger. Цей інструмент створює базові тестові сценарії, які можна запускати в CI/CD середовищах. Kusho підтримує імпорт у популярні формати (Postman, JSON, CSV, TestNG), що дозволяє швидко інтегрувати його з іншими QA-інструментами.

Наразі Kusho – один з найкращих готових продуктів для генерації автотестів за допомогою ШІ. Він має низку важливих переваг:

-

Швидке створення автотестів на основі OpenAPI-специфікацій.

-

Інтеграція з пайплайнами CI/CD.

-

Різноманітні формати експорту тестів.

-

Повний стек функціонального та security-тестування у Pro/Enterprise тарифах.

Але у платформи також є суттєві обмеження. Передусім це слабка підтримка GraphQL та ускладнена інтеграція з AIO Tests. Крім того, доступний для усіх безплатний тариф існує швидше для ознайомлення, ніж для реальної роботи: навіть базова генерація “з'їдає” ліміт застосування дуже швидко. На жаль, наразі Kusho генерує забагато “сміттєвих” тестів.

Локальні LLM

Альтернативою хмарним рішення на кшталт Kusho є застосування локально розгорнутих LLM, таких як Qwen, DeepSeek та LLaMA. Локальні моделі для тестування пропонують повний контроль над даними, можливість кастомного навчання на власних проектах (fine-tuning), відсутність залежності від тарифів SaaS-рішень.

Як приклад, Qwen доступна цілком безкоштовно, розгортається локально та чудово підходить для тонкого налаштування на власних даних. Ця модель добре працює з технічними текстами, генерує достатньо якісні тести на мовах на кшталт Python, добре формує структуру вимог та тест-планів.

Гарним вибором для локального розгортання також є DeepSeek: ця нова open-source модель добре підходить для генерації коду та добре виявляє помилки, хоча наразі й не завжди вірно розуміє контекст та специфіку автотестів. Проте вона працює швидко, добре підходить для інтеграції у внутрішні пайплайни і є дуже перспективною.

Проблема “сміттєвих” тестів та безпека даних

Однією з найбільших проблем хмарних рішень автоматизації QA є низька якість деяких автотестів, які лише створюють ілюзію повного покриття. Такі тести не лише займають ресурси, але й спотворюють уявлення про реальну якість продукту. Іноді складається враження, що “зайві” тести створюються цілеспрямовано – аби з’їдати ліміт безплатної генерації та підштовхувати користувача до переходу на платну версію продукту.

Ще один критично важливий аспект — безпека. Використання хмарних продуктів, що обробляють клієнтські API-специфікації або баг-репорти, несе ризики витоку чутливих даних. Навіть якщо вендор сервісу дбає про безпеку і може показати відповідні сертифікати, бізнес усе частіше утримується від повної інтеграції таких інструментів у sensitive-проекти. Відтак локальні нейромережі для QA стають затребуваними як ніколи.

Як підсумок, можемо детально порівняти локальні LLM з тим же Kusho в окремій таблиці:

| Критерій | Kusho | Qwen / DeepSeek (локальні моделі) |

| Тип рішення | SaaS-сервіс | Open-source LLM, локальне розгортання |

| Фокус | Генерація API-тестів на основі OpenAPI | Генерація автотестів, аналіз багів, робота з вимогами |

| Якість тестів | Базові кейси, часто багато “мусорних” тестів | Більш релевантні сценарії при кастомізації/налаштуванні |

| Гнучкість | Обмежена логікою сервісу, кастомізація — тільки в Enterprise-версії | Обмежена логікою сервісу, кастомізація — тільки в Enterprise-версії |

| Інтеграція з CI/CD | Можлива, але лише в платних тарифах | Можлива через кастомні скрипти та інтеграцію з пайплайнами |

| Формати експорту | JSON, CSV, Postman, TestNG | Будь-який формат, якщо запрограмувати відповідний промпт або конвертер |

| Безпека даних | Дані передаються сторонньому сервісу | Дані не залишають локального контуру |

| Витрати на генерацію | Безкоштовний тариф обмежений, платні — від $20/міс. | Безкоштовно (окрім вартості обчислювальних ресурсів) |

| Підтримка GraphQL | Обмежена | Можна налаштувати під будь-який API (REST/GraphQL) |

| Масштабованість | Потрібна покупка вищого тарифу | Повна масштабованість (на власній інфраструктурі) |

| Висновок | Зручне рішення “із коробки”, але обмежене і не завжди безпечне | Оптимально для команд з високими вимогами до якості та приватності |

Найкращі IDE та плагіни для автоматичного написання автотестів

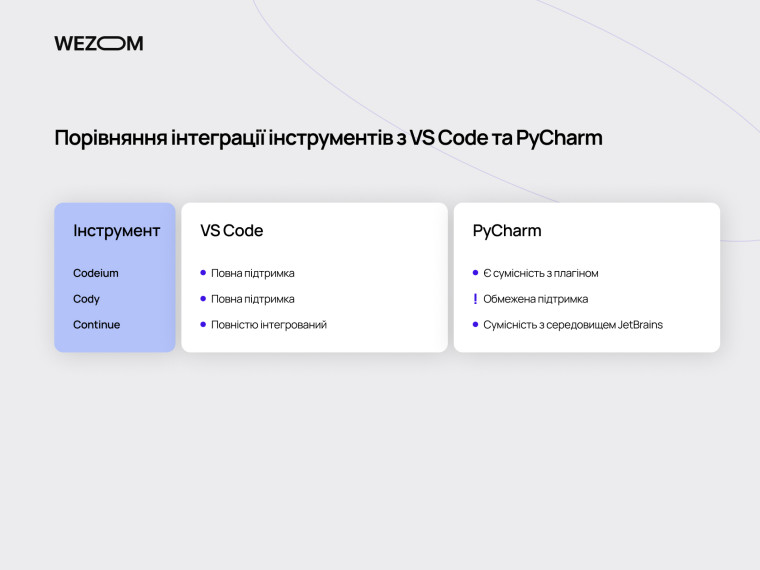

Сьогодні чимало QA-інженерів перейшли від написання тестів вручну до використання AI-помічників, інтегрованих безпосередньо в улюблену IDE. Такі інструменти, як Codeium, Cody та Continue дозволяють генерувати тести за кодом функцій, баг-репортами або вимогами. Дедалі частіше застосування IDE для автоматизації тестування дає кращі результати, ніж класичні скрипти.

Codeium, Cody, Continue: що обрати?

Codeium – це один із найкращих інструментів для генерації коду та автотестів. Він підтримує понад 70 мов програмування, інтегрується з VS Code, IntelliJ, PyCharm і навіть Jupyter. Codeium добре доповнює код, та іноді пропонує застарілі рішення. Найкраще виявляє себе у написанні юніт- та інтеграційних тестів.

Cody – потужний AI-помічник із розширеними можливостями аналізу проєкту. Цей асистент вміє читати структуру репозиторію, працювати з контекстом пул-реквестів та генерувати тести відповідно до структури класів і модулів. Найкраще справляється з автогенерацією тестів на TypeScript і Python. У порівнянні з GitHub Copilot й Tabnine саме асистент Cody найкраще адаптований під тестування.

Continue — lightweight плагін, орієнтований на LLM-асистування в VS Code. Основна фішка — інтеграція з локальними моделями (DeepSeek, Qwen, LLaMA), що робить його ідеальним для проєктів з високими вимогами до безпеки. Його сильні сторони – відмінні можливості інтеграції та простий інтерфейс. Крім того, він безплатний.

На сьогодні це кращі плагіни для автотестів. Як зробити вибір на користь одного з них?

-

Якщо вам важлива універсальність, кросплатформність та загальне автодоповнення коду за мінімальний кошт, обирайте Codeium.

-

Якщо вам потрібні автотести на TypeScript і Python, а можливостей Copilot чи Tabnine для тестування не вистачає, обирайте Cody.

-

Якщо ваш пріоритет – робота з VS Code та PyCharm, а стек базується на Java, Python або JS, обирайте Continue.

Порівняння інтеграції інструментів з VS Code та PyCharm

Найкращі плагіни для автотестів у Java, Python та JS

Проводити порівняння AI інструментів для тестування без розуміння стеку технологій на проєкті не зовсім коректно, адже різні рішення можуть демонструвати різну ефективність в роботі з тими чи іншими технологіями.

Приміром, для автотестів у Java чудово підходить Cody: він добре працює з JUnit та TestNG, враховує структуру класів тощо. Вдалим рішенням також буде Codeium: він добре генерує на Java boilerplate-код для тестів.

В автотестуванні на Python асистент Codeium також демонструє себе дуже добре. У поєднанні з Pytest він може автоматично пропонувати тести до функцій з описом поведінки. Ефективним рішенням також буде Continue, поєднаний з локальними LLM. Така зв’язка дозволяє налаштувати генерацію з урахуванням internal-логіки.

У роботі з JavaScript / TypeScript дуже гідно проявляє себе Cody: він добре працює з Jest, Mocha, Vitest. Універсальний Codeium також виявляється корисним, бо добре поєднується з фронтенд-фреймворками React та Vue.

Якщо дивитися на комплексний стек Java/Python/JS, ми вважаємо найкращим вибором Continue з локальною моделлю ШІ. Такий інструмент можна гнучко налаштувати та інтегрувати під будь-які завдання.

Claude vs ChatGPT vs DeepSeek: який ШІ найкраще генерує автотести?

Генерація автотестів за допомогою великих мовних моделей (LLM) швидко стає стандартом індустрії. Порівняймо провідні моделі – Claude, ChatGPT, DeepSeek та Qwen – яка з них найкраще підходить під завдання QA?

З чого обирати?

Який вибір взагалі є у розробників та тестувальників? Наразі з погляду завдань QA найперспективнішими є такі LLM:

-

ChatGPT – найпопулярніша модель від OpenAI, відома своєю здатністю вести природні діалоги та генерувати код.

-

Claude – це AI-модель від американського стартапу Anthropic, яка фокусується на безпеці та етиці, вдаючись до техніки "конституційного AI".

-

DeepSeek – AI-модель китайського походження, що спеціалізується на глибокому аналізі, багатомовній підтримці та генерації коду.

-

Qwen – серія відкритих мовних моделей від Alibaba Cloud, оптимізованих для багатомовної роботи та складних завдань.

Усі ці LLM певною мірою універсальні, але мають свої сильні та слабкі сторони, а також власні ком’юніті. Профільні форуми забиті тредами на кшталт “Claude vs chatGPT для QA: що краще”. Загалом подібні обговорення мають суто суб’єктивний характер. Але ми, з огляду на наш досвід роботи з різними LLM, підготували невелику таблицю щодо їх можливостей в тестуванні.

Яка модель підходить для створення тест-кейсів на Playwright?

Playwright — популярний фреймворк для e2e-тестування, і не всі LLM однаково добре справляються з його синтаксисом та шаблонами.

З нашого досвіду найкращі результати у створенні автотестів на Playwright “з коробки” показують Claude та GPT-4.

-

Claude здебільшого пише добре структуровані та робочі тести на Python.

-

GPT-4 також підлаштовується під структуру тестів, правильно використовує локатори й контекст.

-

DeepSeek: при кастомних інструкціях здатен генерувати чистий код для Playwright, але вимагає детальних налаштувань і уточнень.

-

Модель Qwen також підходить для базового створення тестів на Playwright, особливо у Python-стеку. Втім її можна розгорнути локально та донавчити для Playwright-проєктів, що забезпечить найвищу точність генерації.

Тож якщо ваша команда активно використовує Playwright, найменше клопоту буде з GPT-4. Для локального сценарію оптимальною буде відповідно навчений Qwen, або ж DeepSeek із попередньо підготовленими шаблонами.

Безпека з локальними LLM (Qwen, LLaMA, DeepSeek)

Великі компанії все частіше відмовляються від SaaS-інструментів і переходять на локальні LLM, такі як Qwen, LLaMA або DeepSeek. Безпечне тестування з локальними LLM мінімізує ризики компрометації або втрати даних, оскільки пропонує низку переваг:

- 🔒 Дані не покидають контур компанії — жодних витоків через API-запити.

- ⚙️ Повна кастомізація — модель можна донавчити на реальних тестах проєкту.

- 🧩 Інтеграція у внутрішні пайплайни — автоматична генерація тестів у CI/CD.

Відтак варто окремо поглянути на LLM, що придатні до локального розгортання у закритому контурі.

-

Qwen. Відмінний вибір для локального використання та налаштування на власних даних. Достатньо універсальний та ефективний у завданнях QA, реалізує увесь свій потенціал після локального донавчання.

-

LLaMA: Лідер серед open-source LLM. Ця модель добре працює офлайн, швидка та підходить для кастомних рішень. Однак це не найкращий AI для аналізу багів та написання коду – без тонкого налаштування результати будуть посередніми.

-

DeepSeek. Локально встановлювана модель, що активно розвивається. Цей ШІ добре справляється з кодогенерацією, підтримує кілька мов, має мінімальні вимоги до інфраструктури і чудово масштабується.

Вибір однієї з LLM для локального запуску залежить від ресурсів та завдань бізнесу. У наших завданнях ми надали перевагу моделі Qwen2.5, яку навчаємо під власні потреби.

Інтеграція ШІ в QA-процеси: практичні кейси

Сьогодні автоматизація QA – це далеко не одне лише автоматичне написання автотестів. Штучний інтелект стрімко проникає в саму тканину процесу розробки — від аналізу вимог до запуску тестів у production-середовищі. Давайте подивимось, як це працює на практиці.

Один з найперспективніших напрямів – автоматична генерація тестів прямо в CI/CD процесах, без безпосереднього залучення людини на кожному кроці. Типовий сценарій виглядає так:

-

Розробник комітить код + оновлює Swagger / OpenAPI-специфікацію.

-

У пайплайні запускається генерація тестів за допомогою LLM або сервісу на кшталт Kusho.

-

Генератори (наприклад, DeepSeek або Qwen) формують тести, які автоматично додаються до smoke suite.

-

CI-сервер (наприклад, Jenkins або GitHub Actions) запускає згенеровані тести, публікує звіти, а результати стають доступними QA-команді.

Пайплайни тестування в CI/CD з ШІ вже довели свою ефективність на практиці. Вони забезпечують прискорення усього циклу розробки та скорочують навантаження на команду. Однак вони потребують розв'язання проблем “сміттєвих” тестів та правильного врахування контексту на рівні моделей ШІ.

Розумна зв`язка Windsurf + LLM

Windsurf — це інтелектуальне середовище для тестування, що підтримує декілька потужних LLM-агентів (Claude, ChatGPT) та технологію Cascade, яка забезпечує глибоке контекстне розуміння кодової бази, дозволяючи редагувати кілька файлів одночасно і зберігати логіку проєкту.

Інтеграція Windsurf одразу з декількома моделями ШІ дозволяє вирішувати широке коло завдань:

-

Claude аналізує баги, логіку тестів, пропонує покращення сценаріїв.

-

ChatGPT генерує автотести, шаблони для Playwright, Cypress, Pytest тощо.

-

Cascade допомагає у контекстному розумінні проєкту, аналізі залежностей і сценаріїв.

І все це працює в режимі “асистента в IDE” — без потреби в перемиканні на сторонні сервіси. Крім того, Windsurf добре інтегрується з Git, Slack та Jira. Цей інструмент все частіше розглядають як повноцінну альтернативу традиційним IDE на кшталт PyCharm та IntelliJ IDEA, особливо для QA-команд.

Тестування API за допомогою ШІ: GitHub, Jenkins, Bitbucket

Інтеграція ШІ-інструментів у звичні DevOps-сервіси значно спрощує роботу з API-тестуванням. Ось кілька практичних кейсів:

-

GitHub: генерація тестової документації (через Mintlify або ChatGPT), автозапуск тестів після merge.

-

Jenkins: запуск генераторів (наприклад, DeepSeek, Qwen) у pre- або post-build скриптах. Також можна інтегрувати AI-модуль як окремий step.

-

Bitbucket: через CLI-інтерфейси можна автоматизувати перевірку пул-реквестів на наявність тестів, використовувати AI для автокоментарів або створення чеклистів.

Відтак інструменти для API-тестування ще ніколи не були такими зручними, доступними та ефективними. Понад те, розробники отримують змогу автоматизувати не лише виконання тестів, але й аналітику й документування.

Як налагодити автоматизоване документування тестів

У світі автоматизації QA все ще залишається непомітний, але важливий фронт – ведення документації. Якісне автоматичне документування тестів може значно спростити їхнє розуміння та процес підтримки. Розглянемо основні підходи та інструменти на цьому шляху.

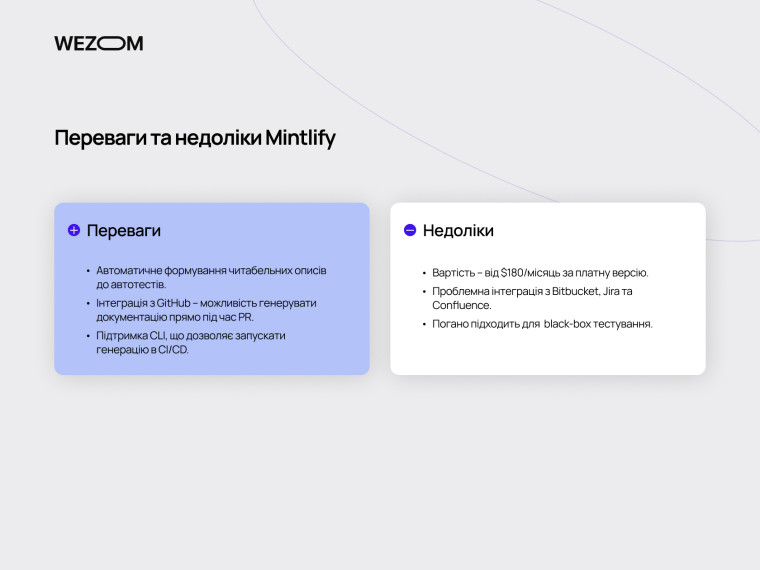

Mintlify: переваги та недоліки

Одним з найпопулярніших рішень для автоматичного документування коду є Mintlify. Цей інструмент вміє генерувати текстовий опис функцій, класів, автотестів, створює документацію до пул-реквестів, має інтеграції з GitHub та VS Code.

У Mintlify є безумовні переваги:

-

Автоматичне формування читабельних описів до автотестів;

-

Інтеграція з GitHub – можливість генерувати документацію прямо під час PR;

-

Підтримка CLI, що дозволяє запускати генерацію в CI/CD.

Але разом з тим рішення має і недоліки:

-

Вартість – від $180/місяць за платну версію. Саме у цій версії доступна більша частина функціоналу на базі ШІ;

-

Проблемна інтеграція з Bitbucket, Jira та Confluence – ці інструменти підтримуються лише через “милиці” та обхідні шляхи;

-

Специфіка black-box тестування значною мірою ігнорується. Mintlify все ж є інструментом передусім для розробників, а не для AQA-інженерів.

Як результат, Mintlify – сильний інструмент для команд розробників, але для QA він може бути надмірно дорогим та обмеженим, особливо у нестандартних стекових умовах (Bitbucket, Jenkins, Jira).

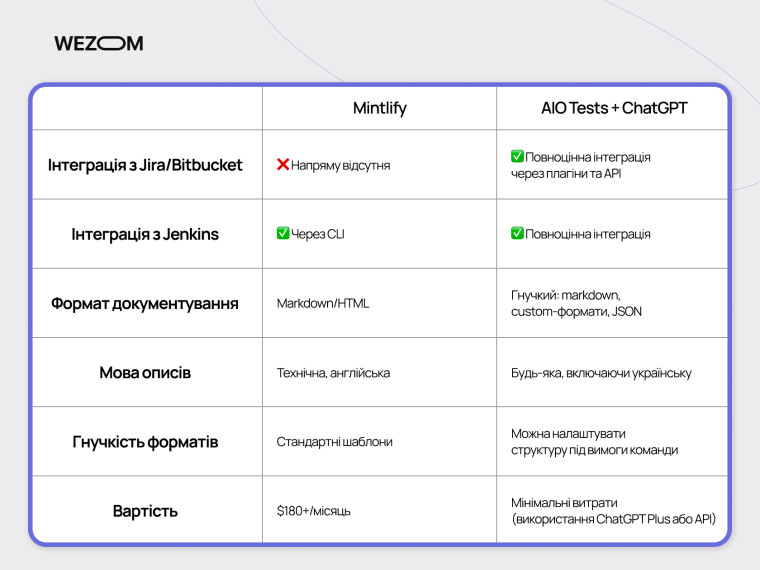

Mintlify vs внутрішні рішення (AIO Tests + ChatGPT)

Альтернативою продуктам на кшталт Mintlify може бути використання внутрішніх рішень. Наприклад, інтеграція ChatGPT в AIO Tests дозволяє автоматизувати створення тестових сценаріїв. Такий підхід може бути дешевшим та ефективнішим. Як приклад, давайте порівняємо підходи за найважливішими критеріями для стеку WEZOM

Відтак наш досвід застосування зв’язки AIO Tests та ChatGPT для документації тестування в реальних проєктах виявився позитивним та перспективним.

Автоматичне документування через markdown та CI/CD

Найпростіший, але водночас і найуніверсальніший підхід – генерація тестової документації у форматі Markdown з подальшою публікацією через CI/CD пайплайн. Використання markdown як формату забезпечує гнучкість та переносність документації між різними платформами.

Як це працює? Наведемо механізм у двох словах:

- При коміті нового автотесту генератор (наприклад, скрипт з ChatGPT API або внутрішній плагін AIO Tests) формує .md-файл з описом.

- CI/CD (наприклад, Jenkins або GitHub Actions) автоматично:

- додає документацію до pull request;

- копіює її у відповідну wiki/Confluence/сторінку проєкту;

оновлює changelog або release notes.

Ця формула дає важливі переваги: опис тестів створюється разом із самими тестами, тож документація завжди відповідає актуальному коду. Цей механізм легко інтегрується з Bitbucket або Jenkins. Однак для успіху такого підходу потрібна налагоджена система генерації .md-файлів та правильна конфігурація CI/CD пайплайнів.

Локальні LLM: безпека та fine-tuning

Вище ми вже торкалися питань безпеки при застосуванні великих мовних моделей. Чи можна довіряти код із клієнтськими даними хмарним ШІ-моделям? Наскільки безпечним є тестування з допомогою chatGPT та інших подібних моделей? Локальне розгортання LLM дозволяє зняти ці перестороги та забезпечити безпечне тестування в закритому контурі.

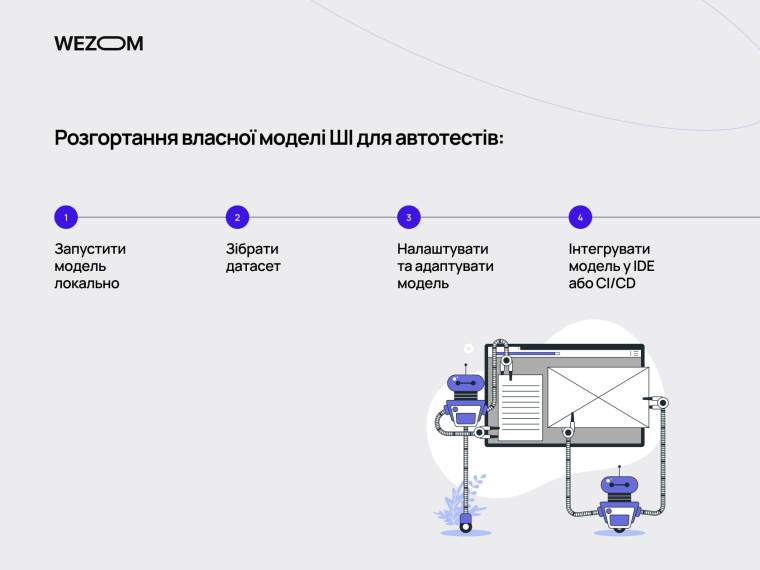

Як навчити власну LLM

З нашого досвіду, однією з найкращих моделей для локального використання в QA є Qwen2.5-coder-7B. Це відкрита модель, оптимізована для написання коду, включаючи автотести на Python та JS.

Щоб перетворити її на вашого внутрішнього QA-помічника, потрібно:

- Запустити модель локально через Ollama або HuggingFace (про це нижче).

- Зібрати датасет з прикладів реальних автотестів вашої компанії.

- Налаштувати та адаптувати модель, аби вона "вивчила" ваш стиль написання, структуру тестів, інструментарій тощо.

- Інтегрувати модель у вашу IDE або CI/CD. Наприклад, через Continue-плагін або REST-інтерфейс.

Навчена таким чином модель буде враховувати ваші стандарти, контекст та особливості продукту. І все це – з мінімальним ризиком витоку даних.

Ліцензування, запуск через Ollama, HuggingFace, LM Studio

При роботі з локальними LLM важливо враховувати питання ліцензування та вибору інструментів для їхнього запуску. Різні моделі мають різні ліцензії, які визначають умови їхнього використання, модифікації та розповсюдження. Необхідно ретельно вивчити ліцензію кожної моделі перед її використанням.

Крім того, існує низка інструментів запуску локальних моделей.

-

Ollama: Інструмент для запуску та управління LLM на локальній машині.

-

HuggingFace: Платформа, що надає доступ до багатьох LLM та інструментів для їхнього навчання та розгортання.

-

LM Studio: Інструмент, що дозволяє легко запускати LLM на локальних машинах, з акцентом на зручність використання.

Вибір конкретного інструменту залежить від технічних вимог, доступних ресурсів та вподобань команди розробників.

Безпека тестування

Чому все більше компаній уникають використання ChatGPT або Claude? Ризик витоку даних існує завжди, навіть якщо вендор гарантує конфіденційність та має сертифікати безпеки. Випадки, коли загальнодоступна модель згодом відтворювала фрагменти приватного коду, вже траплялись.

Використання локальних LLM дає повний контроль над інформацією:

-

Дані ніколи не покидають локальну інфраструктуру.

-

Можна задати whitelist директорій або API, з якими працює модель.

-

Локальне зберігання промптів, логів, результатів генерації — без сторонніх серверів.

-

Ізоляція середовища – модель можна запустити на окремому хості або у VPN-сегменті.

Кастомний підхід

Локальне навчання моделей також незамінне в реалізації кастомних сценаріїв QA, особливо коли йдеться про автоматизацію у закритому середовищі, адаптацію під специфіку продукту та використання в ізольованих пайплайнах. Для таких завдань підходить не лише згадана вище модель Qwen, але й опенсорсні LLM DeepSeek та LLaMA.

-

DeepSeek непогано пише код “з коробки”, але якщо її окремо донавчити на якісному датасеті, то можна домогтися дійсно відмінних результатів. Вона підтримує локальне розгортання, активно розвивається спільнотою та відмінно інтегрується з такими інструментами, як Continue чи OpenWebUI. Відтак застосування Deepseek для генерації тестів – це шлях, до якого вдаються все більше команд QA.

-

Водночас моделі LLaMA (13B або 34B) – це оптимальний вибір для команд, які хочуть глибоко кастомізувати свій ШІ: адаптація до внутрішньої термінології, fine-tuning на нетипових датасетах тощо. У стані “з коробки” LLaMA генерація коду LLaMA не вражає, але натомість модель пропонує стабільність і продуктивність.

Обидві моделі дозволяють уникнути передачі даних у хмару, масштабуються під потреби команди та підтримують повну кастомізацію — від типу автотестів до специфіки стилю коду.

Висновки

Просто зараз автоматизоване тестування переживає чергову трансформацію — під впливом великих мовних моделей, глибокої інтеграції QA з DevOps та нових вимог до безпеки. Сучасні інструменти автоматизації QA вже не просто допомагають писати тести — вони аналізують баги, формують тест-кейси з опису вимог, запускаються в CI/CD та генерують якісну документацію. Як не розгубитися у нових можливостях та обрати правильні інструменти QA?

-

Для невеликих QA-команд та fast-paced стартапів чудово підійдуть легкі та безплатні інструменти на кшталт Codeium або Continue з інтеграцією у VS Code. Вони забезпечують швидкий та якісний результат із мінімальним налаштуванням.

-

Для середніх та великих команд рекомендується застосовувати Cody або Windsurf – як потужні середовища з глибоким контекстом коду, AI-асистентами та підтримкою кількох мов тестування.

-

Для команд з високими вимогами до безпеки критично важливо переходити на локальні LLM: Qwen, DeepSeek, LLaMA тощо Вони дозволяють уникнути витоку даних, кастомізуються під внутрішні стандарти і легко інтегруються у CI/CD пайплайни.

-

Для API-тестування та автоматичної документації не варто покладатись на дорогі SaaS-рішення, якщо вони не інтегруються у вашу екосистему. Краще побудувати пайплайн на базі ChatGPT, AIO Tests і власних markdown-шаблонах.

Наша загальна рекомендація: 2025 — це рік переходу від хмарних “помічників” до власних, безпечних, інтегрованих AI-асистентів у QA, які не лише генерують код, а й розуміють контекст проєкту, вимоги бізнесу та специфіку командних процесів.

Майбутнє автоматизованого QA криється у творчій синергії людини та ШІ. LLM вже сьогодні можуть багато, але саме людина визначає планку якості, ризики та цінність тестів. Найефективніший підхід — це сильний AI у руках уважного QA-інженера. Машини не будуть замінювати людей – вони будуть відкривати нові можливості.