Область контроля качества софта постоянно развивается. Скорость разработки растет, сложность систем увеличивается. Как итог, растет и потребность в эффективных и надежных инструментах для автотестов. Еще несколько лет назад автоматизация тестирования программного обеспечения концентрировалась вокруг классических фреймворков QA, но сегодня мы наблюдаем кардинальное смещение в подходах. Теперь в центре внимания – инструменты на базе ИИ, большие языковые модели (LLM), генерация тестов на основе описания требований, глубокая интеграция с CI/CD-процессами и т.д. Проверенные годами технологии стремительно теряют актуальность, но изучение новых решений требует времени и ресурсов.

Как эффективно автоматизировать процессы QA в реалиях 2025 года? В этой статье мы разберем самые актуальные инструменты и решения, позволяющие вывести тестирование на новый уровень. Рассмотрим ключевые тренды, сравним популярные IDE, оценим возможности генераторов API-тестов и исследуем потенциал больших языковых моделей. Этот небольшой обзор будет полезным как для начинающих тестировщиков, так и для опытных QA-инженеров.

Главные тренды автоматизации

Сегодня автоматизация QA вышла за рамки традиционного автотестирования. Теперь это – об умных системах, которые интегрируются в жизненный цикл разработки и способны самостоятельно генерировать, адаптировать и выполнять тесты, формировать и дополнять документацию, анализировать баги и требования. Рассмотрим технологии, заложившие основу для этих новых решений.

Искусственный интеллект и LLM

Прямо сейчас интеграция ИИ в QA-процессы полностью меняет подходы к контролю качества. Такие средства как большие языковые модели (LLM – Large Language Models) могут взять на себя множество рутинных задач:

-

Анализ документации и автоматизированное создание тест-кейсов;

-

Генерация кода автотестов по простому текстовому описанию;

-

Проведение ревью тестов или автопоиск слабых мест в покрытии;

-

Определение наиболее критичных сценариев для проверки.

Инструменты на базе GPT-подобных моделей уже стали частью повседневной работы QA-команд – как в виде встроенных помощников в IDE, так и через внешние сервисы.

Генерация тестов на основе описания требований

Сегодня вместо ручного написания десятков сценариев QA-специалист может предоставить специализированному инструменту требования в свободной форме или в виде user story, а в ответ получить:

-

Набор многофункциональных автотестов.

-

Тестовые примеры для edge-case ситуаций.

-

UI-макеты с готовыми проверками

Этот подход значительно ускоряет старт тестирования, особенно в fast-paced Agile командах.

Тесная интеграция QA в CI/CD-пайплайны

Направление QA больше не изолировано – оно становится частью DevOps-культуры. В современных процессах CI/CD (Continuous Integration/Continuous Delivery) новейшие инструменты дают ряд возможностей:

-

Тесты запускаются при каждом коммите, пул-реквесте или деплое.

-

Результаты тестирования влияют на решение о выводе новой версии в продакшн.

-

Для изолированного тестирования используются динамические среды.

Это не только обеспечивает быстрый фидбек по качеству, но и создает культуру ответственности за стабильность продукта на всех этапах.

Low-code/no-code автоматизация

В то же время растет спрос на инструменты, позволяющие создавать автотесты без глубоких знаний языков программирования. Такие платформы:

-

Дают возможность быстро строить тесты через интерфейсы drag-and-drop.

-

Доступны для мануальных тестировщиков, бизнес-аналитиков и других non-tech участников процесса.

-

Прекрасно интегрируются с традиционными фреймворками через API или коннекторы.

Преимущества подобных решений особенно хорошо проявляются в небольших проектах, при создании MVP, прототипов и т.д.

Фокус на тестах API и контрактном тестировании

В 2025 году все больше команд QA концентрируются на тестировании API как основы проверки логики приложений. На это есть несколько причин:

-

API-тесты быстрее, стабильнее и дешевле в поддержке, чем UI-тесты.

-

Контрактное тестирование помогает выявить несовместимость между микросервисами до релиза.

-

Многие инструменты (например, Postman, Pact, RestAssured) теперь поддерживают автоматическую генерацию и валидацию контрактов.

Приведенные тренды не только меняют инструменты, которыми мы пользуемся – они трансформируют саму роль QA на проекте, вовлекают контроль качества во все этапы разработки.

Генерация автотестов с ИИ: инструменты, меняющие QA

LLM-модели и специализированные ИИ-сервисы открыли возможность создавать тесты практически “из воздуха” – из документации, user story или спецификаций OpenAPI Давайте рассмотрим подобные решения, доступные тестировщикам прямо сейчас.

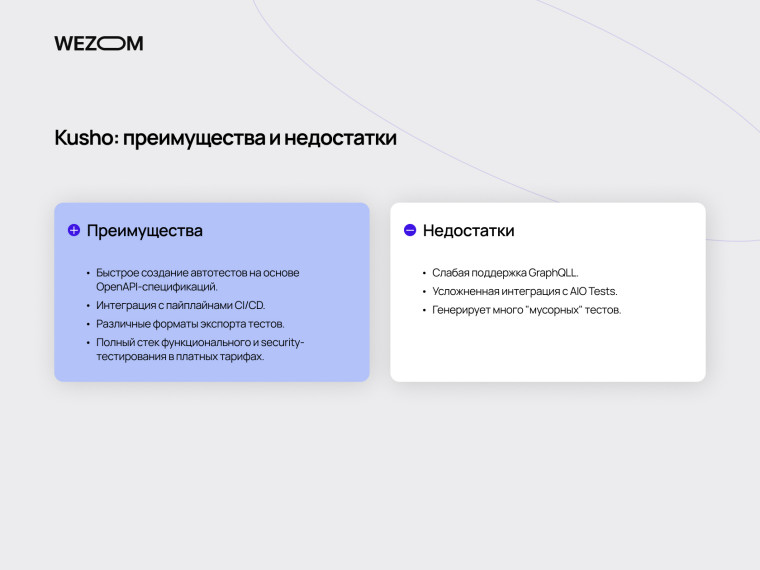

Kusho: генерация API-тестов

Популярная AI-платформа Kusho – очень востребованное решение для автоматизированного тестирования. Она специализируется на генерации тестов API с использованием OpenAPI/Swagger. Этот инструмент создает базовые тестовые сценарии, которые можно запускать в среде CI/CD. Kusho поддерживает импорт в популярные форматы (Postman, JSON, CSV, TestNG), что позволяет быстро интегрировать его с другими QA-инструментами.

На сегодня Kusho – один из лучших готовых продуктов для генерации автотестов с помощью ИИ. Он имеет ряд важных преимуществ:

-

Быстрое создание автотестов на основе OpenAPI-спецификаций

-

Интеграция с пайплайнами CI/CD.

-

Различные форматы экспорта тестов.

-

Полный стек функционального и security-тестирования в Pro/Enterprise тарифах.

Но у платформы есть и существенные ограничения. Прежде всего, это слабая поддержка GraphQL и усложненная интеграция с AIO Tests. Кроме того, доступный для всех бесплатный тариф существует скорее для ознакомления, чем для реальной работы: даже базовая генерация съедает лимит использования очень быстро. К сожалению, сейчас Kusho генерирует слишком много "мусорных" тестов.

Локальные LLM

Альтернативой облачным решениям типа Kusho является применение локально развернутых LLM, таких, как Qwen, DeepSeek та LLaMA. Локальные модели для тестирования предлагают полный контроль над данными, возможность кастомного обучения на собственных проектах (fine-tuning), отсутствие зависимости от тарифов SaaS-решений.

Как пример, Qwen доступна совершенно бесплатно, разворачивается локально и прекрасно подходит для тонкой настройки на собственных данных. Эта модель хорошо работает с техническими текстами, генерирует достаточно качественные тесты на языках типа Python, хорошо формирует структуру требований и тест-планов.

Хорошим выбором для локального развертывания также является DeepSeek: эта новая open-source модель хорошо подходит для генерации кода и хорошо обнаруживает ошибки, хотя и не всегда понимает контекст и специфику автотестов. Однако она работает быстро, хорошо подходит для интеграции во внутренние пайплайны и очень перспективна.

Проблема "мусорных" тестов и безопасность данных

Одной из самых больших проблем облачных решений автоматизации QA является низкое качество некоторых автотестов, которые только создают иллюзию полного покрытия. Такие тесты не только занимают ресурсы, но и искажают представление о реальном качестве продукта. Иногда создается впечатление, что "лишние" тесты создаются целенаправленно – чтобы съедать лимит бесплатной генерации и подталкивать пользователя к переходу на платную версию продукта.

Еще один критически важный аспект – безопасность. Использование облачных продуктов, обрабатывающих клиентские API-спецификации или баг-репорты, несет риски утечки чувствительных данных. Даже если вендор сервиса заботится о безопасности и может показать соответствующие сертификаты, бизнес все чаще воздерживается от полной интеграции таких инструментов в sensitive-проекты. Как итог, локальные нейросети для QA становятся востребованными как никогда.

Чтобы сделать небольшие выводы, мы можем подробно сопоставить локальные LLM с тем же Kusho в отдельной таблице:

| Критерий | Kusho | Qwen/DeepSeek (локальные модели) |

| Тип решения | SaaS-сервис | Open-source LLM, локальное развертывание |

| Фокус | Генерация API-тестов на основе OpenAPI | Генерация автотестов, анализ багов, работа с требованиями |

| Качество тестов | Базовые кейсы, часто много "мусорных" тестов | Более релевантные сценарии при кастомизации/настройке |

| Гибкость | Ограниченная логикой сервиса, кастомизация – только в Enterprise-версии | Полная свобода промптов, возможно обучать модель на собственных кейсах |

| Интеграция с CI/CD | Возможна, но только в платных тарифах | Возможна через кастомные скрипты и интеграцию с пайплайнами |

| Форматы экспорта | JSON, CSV, Postman, TestNG | Любой формат, если запрограммировать соответствующий промпт или конвертер |

| Безопасность данных | Данные передаются стороннему сервису | Данные не покидают локального контура |

| Расходы на генерацию | Бесплатный тариф ограничен, платные — от $20/мес. | Бесплатный тариф ограничен, платные — от $20/мес. |

| Поддержка GraphQL | Ограничена | Можно настроить под любой API (REST/GraphQL) |

| Масштабируемость | Нужна покупка более высокого тарифа | Полная масштабируемость (на собственной инфраструктуре) |

| Вывод | Удобное решение "из коробки", но с рядом ограничений и рисков | Оптимально для команд с высокими требованиями к качеству и защите данных |

Лучшие IDE и плагины для автоматического написания автотестов

Сегодня многие QA-инженеры перешли от написания тестов вручную к использованию AI-помощников, интегрированных непосредственно в любимую IDE. Такие инструменты, как Codeium, Cody и Continue позволяют генерировать тесты по коду функций, баг-репортам или требованиям. Все чаще применение IDE для автоматизации тестирования дает более качественные результаты, чем классические скрипты.

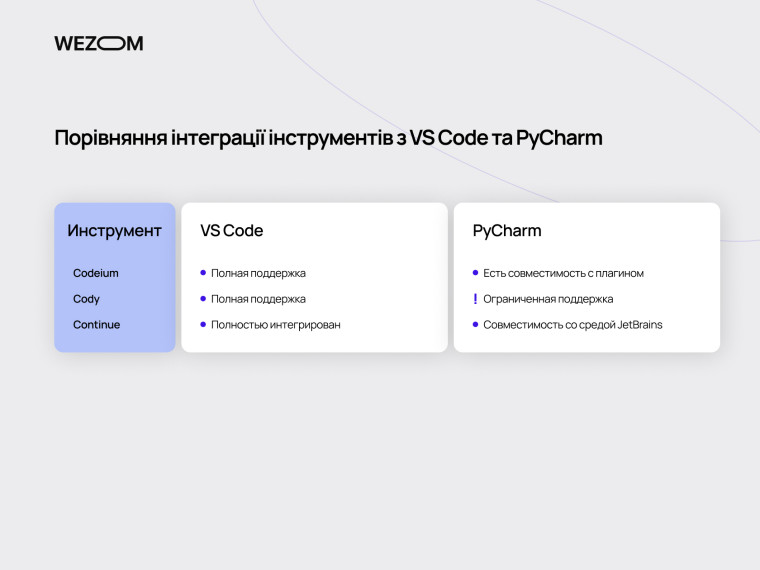

Codeium, Cody, Continue: что выбрать?

Codeium – это один из лучших инструментов для создания кода и автотестов. Он поддерживает более 70 языков программирования, интегрируется с VS Code, IntelliJ, PyCharm и даже Jupyter. Codeium хорошо дополняет код, но иногда предлагает устаревшие решения. Лучше всего проявляет себя в написании юнит- и интеграционных тестов.

Cody – мощный AI-помощник с расширенными возможностями анализа проекта. Этот ассистент умеет читать структуру репозитория, работать с контекстом пул-реквестов и генерировать тесты в соответствии со структурой классов и модулей. Лучше всего справляется с автогенерацией тестов на TypeScript и Python. По сравнению с GitHub Copilot и Tabnine именно ассистент Cody наилучшим образом адаптирован под тестирование.

Continue – lightweight плагин, ориентированный на LLM-ассистирование в VS Code. Основная фишка – интеграция с локальными моделями (DeepSeek, Qwen, LLaMA), что делает его идеальным для проектов с высокими требованиями к безопасности. Его сильные стороны – отличные возможности интеграции и простой интерфейс. Кроме того, он бесплатный.

На сегодняшний день это лучшие плагины для автотестов. Как сделать выбор в пользу одного из них?

-

Если вам важна универсальность, кроссплатформенность и общее дополнение кода с минимальными затратами, выбирайте Codeium.

-

Если вам нужны автотесты на TypeScript и Python, а возможностей Copilot или Tabnine для тестирования не хватает, выбирайте Cody.

-

Если ваш приоритет – работа с VS Code и PyCharm, а стек базируется на Java, Python или JS, выбирайте Continue.

Сравнение интеграции инструментов с VS Code и PyCharm

Лучшие плагины для автотестов в Java, Python и JS

Проводить сравнение AI инструментов для тестирования без понимания стека технологий на проекте не совсем корректно, ведь разные решения могут демонстрировать различную эффективность в работе с теми или иными технологиями.

К примеру, для автотестов в Java отлично подходит Cody: он хорошо работает с JUnit и TestNG, учитывает структуру классов и т.д. Удачным решением также будет Codeium: он хорошо генерирует на Java boilerplate код для тестов.

В автотестировании на Python асистент Codeium также демонстрирует себя очень хорошо. В сочетании с Pytest он может автоматически предлагать тесты для функций с описанием поведения. Эффективным решением также будет Continue, совмещенный с локальными LLM. Такая связка позволяет настроить генерацию с учетом internal-логики.

В работе с JavaScript/TypeScript очень достойно проявляет себя Cody: он хорошо работает с Jest, Mocha, Vitest. Универсальный Codeium также оказывается полезным, потому что хорошо сочетается с фронтенд-фреймворками React и Vue.

Если смотреть на комплексный стек Java/Python/JS, мы считаем лучшим выбором Continue с локальной моделью ИИ. Такой инструмент можно гибко настроить и интегрировать в любые задачи.

Claude vs ChatGPT vs DeepSeek: какой ИИ лучше всего генерирует автотесты?

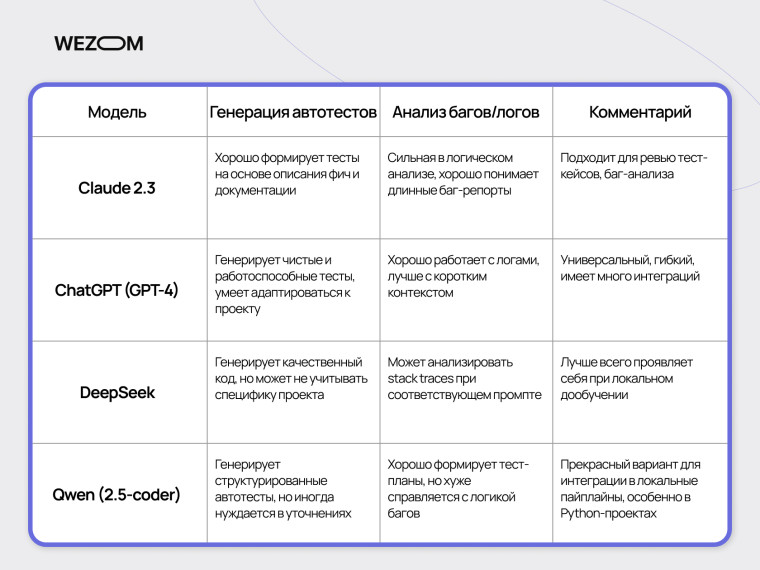

Генерация автотестов с помощью больших языковых моделей (LLM) быстро становится стандартом индустрии. Давайте сравним ведущие модели - Claude, ChatGPT, DeepSeek и Qwen - какая из них лучше всего подходит под задачи QA?

Из чего выбирать?

Какой выбор вообще есть у разработчиков и тестировщиков? На сегодня с точки зрения задач QA наиболее перспективны следующие LLM:

-

ChatGPT – самая популярная модель OpenAI, известная своей способностью вести естественные диалоги и генерировать код.

-

Claude – это AI-модель от американского стартапа Anthropic, которая фокусируется на безопасности и этике, прибегая к технике "конституционного AI".

-

DeepSeek – AI-модель китайского происхождения, специализирующаяся на глубоком анализе, многоязычной поддержке и генерации кода.

-

Qwen – серия открытых языковых моделей Alibaba Cloud, оптимизированных для многоязычной работы и сложных задач.

Все эти LLM в определенной степени универсальны, но имеют свои сильные и слабые стороны, а также собственные коммьюнити. Профильные форумы забиты тредами наподобие “Claude vs chatGPT для QA: что лучше”. В целом подобные обсуждения носят сугубо субъективный характер. Но мы, учитывая наш опыт работы с разными LLM, подготовили небольшую таблицу по их возможностям в тестировании.

Какая модель подходит для создания тест-кейсов на Playwright?

Playwright - популярный фреймворк для e2e-тестирования, и не все LLM одинаково хорошо справляются с его синтаксисом и шаблонами.

По нашему опыту самые лучшие результаты в создании автотестов на Playwright “из коробки” показывают Claude и GPT-4.

-

Claude в основном пишет хорошо структурированные и рабочие тесты на Python.

-

GPT-4 также подстраивается под структуру тестов, правильно использует локаторы и контекст.

-

DeepSeek при кастомных инструкциях способен генерировать чистый код для Playwright, но требует подробных настроек и уточнений.

-

Модель Qwen также подходит для базового создания тестов на Playwright, особенно в Python-стеке. Впрочем, ее можно развернуть локально и доучить для Playwright-проектов, что обеспечит наивысшую точность генерации.

Если ваша команда активно использует Playwright, меньше всего хлопот будет с GPT-4. Для локального сценария оптимальной будет соответственно обученный Qwen или DeepSeek с предварительно подготовленными шаблонами.

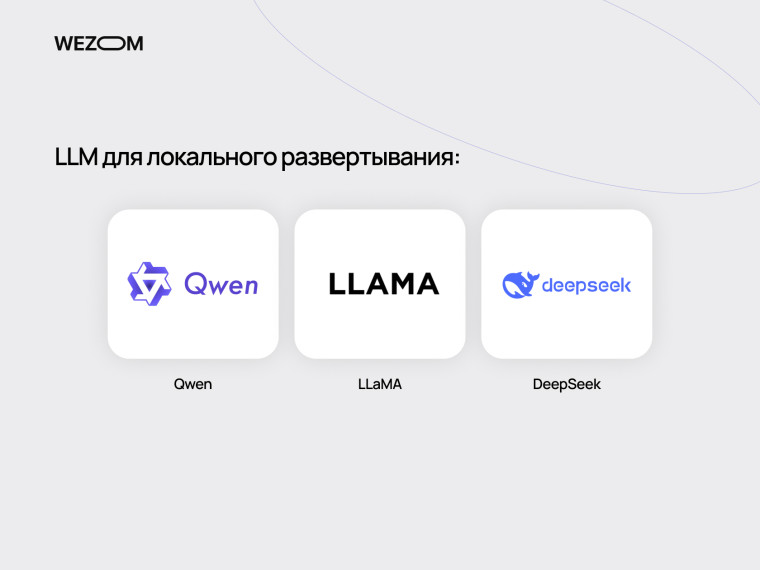

Безопасность с локальными LLM (Qwen, LLaMA, DeepSeek)

Крупные компании все чаще отказываются от SaaS-инструментов и переходят на локальные LLM, такие, как Qwen, LLaMA или DeepSeek. Безопасное тестирование с локальными LLM минимизирует риски компрометации или потери данных, поскольку предлагает ряд преимуществ:

- 🔒 Данные не покидают контур компании — никаких утечек через API-запросы.

- ⚙️ Полная кастомизация модель можно доучить на реальных тестах проекта.

- 🧩 Интеграция во внутренние пайплайны - автоматическое генерирование тестов в CI/CD.

Как результат, стоит отдельно взглянуть на LLM, пригодные к локальному развертыванию в закрытом контуре.

-

Qwen. Отличный выбор для локального использования и настройки на собственных данных. Достаточно универсален и эффективен в задачах QA, реализует весь свой потенциал после локального обучения.

-

LLaMA. Лидер среди open-source LLM Эта модель хорошо работает офлайн, быстра и подходит для кастомных решений. Но это не самый лучший AI для анализа багов и написания кода – без тонкой настройки результаты будут посредственными.

-

DeepSeek. Эта модель активно развивается и может развертываться локальна. Она хорошо справляется с кодогенерацией, поддерживает несколько языков, имеет минимальные требования к инфраструктуре и отлично масштабируется.

Выбор одного из LLM для локального запуска зависит от ресурсов и задач бизнеса. В наших задачах мы отдали предпочтение модели Qwen2.5, которую обучаем под собственные нужды.

Интеграция ИИ в QA-процессы: практические кейсы

Сегодня автоматизация QA – это далеко не одно только автоматическое написание автотестов. Искусственный интеллект стремительно проникает в саму ткань процесса разработки – от анализа требований до запуска тестов в production-среде. Давайте посмотрим, как это работает на практике.

Одно из самых перспективных направлений – автоматическая генерация тестов прямо в CI/CD процессах, без непосредственного вовлечения человека на каждом шагу Типичный сценарий выглядит так:

-

Разработчик комитирует код + обновляет Swagger/OpenAPI-спецификацию.

-

В пайплайне запускается генерация тестов с помощью LLM или сервиса типа Kusho.

-

Генераторы (например, DeepSeek или Qwen) формируют тесты, которые автоматически добавляются в smoke suite.

-

CI-сервер (например, Jenkins или GitHub Actions) запускает сгенерированные тесты, публикует отчеты, а результаты становятся доступными команде QA.

Пайплайны тестирования в CI/CD с ИИ уже доказали свою эффективность на практике. Они обеспечивают ускорение всего цикла разработки и сокращают нагрузку на команду. Однако они требуют решения проблем “мусорных” тестов и правильного учета контекста на уровне моделей ИИ.

Умная связка Windsurf + LLM

Windsurf – это интеллектуальная среда для тестирования, поддерживающая несколько мощных LLM-агентов (Claude, ChatGPT) и технологию Cascade, обеспечивающую глубокое контекстное понимание кодовой базы, позволяя редактировать несколько файлов одновременно и сохранять логику проекта.

Интеграция Windsurf сразу с несколькими моделями ИИ позволяет решать широкий круг задач:

-

Claude анализирует баги, логику тестов, предлагает улучшение сценариев.

-

ChatGPT генерирует автотесты, шаблоны для Playwright, Cypress, Pytest и т.д.

-

Cascade помогает в контекстном понимании проекта, анализе зависимостей и сценариев.

И все это работает в режиме "ассистента в IDE" - без необходимости переключаться на сторонние сервисы. Кроме того, Windsurf хорошо интегрируется с Git, Slack и Jira. Этот инструмент всё чаще рассматривают как полноценную альтернативу традиционным IDE вроде PyCharm и IntelliJ IDEA, особенно для QA-команд.

Тестирование API с помощью ИИ: GitHub, Jenkins, Bitbucket

Интеграция ИИ-инструментов в привычные DevOps-сервисы значительно упрощает работу с API-тестированием. Вот несколько практичных кейсов:

-

GitHub: генерация тестовой документации (через Mintlify или ChatGPT), автозапуск тестов после merge.

-

Jenkins: запуск генераторов (например DeepSeek, Qwen) в pre- или post-build скриптах. Также можно интегрировать AI-модуль как отдельный step.

-

Bitbucket: через CLI-интерфейсы можно автоматизировать проверку пул-реквестов на наличие тестов, использовать AI для автокомментариев или создание чеклистов.

Как результат, инструменты для API-тестирования никогда еще не были такими удобными, доступными и эффективными. Более того, разработчики получают возможность автоматизировать не только выполнение тестов, но также аналитику и документирование.

Как наладить автоматизированное документирование тестов

В мире автоматизации QA все еще остается незаметный, но важный фронт – ведение документации. Качественное автоматическое документирование тестов может значительно упростить их понимание и процесс поддержки. Рассмотрим основные подходы и инструменты на этом пути.

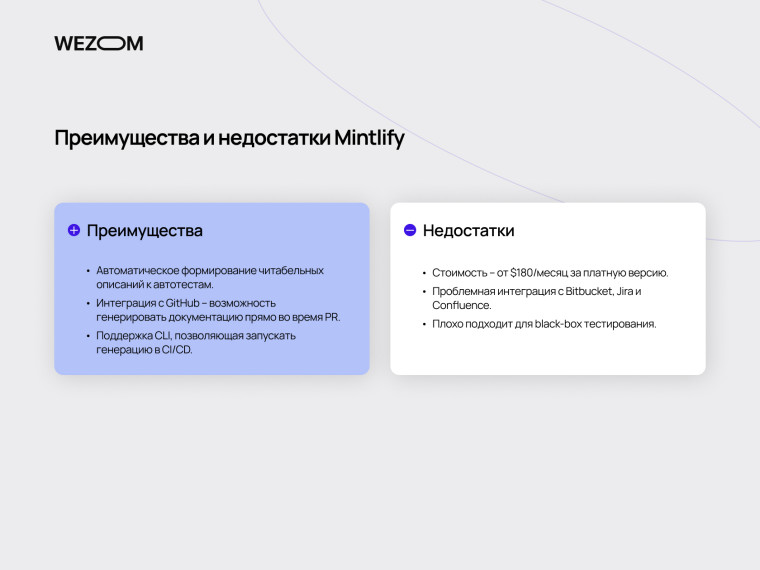

Mintlify: преимущества и недостатки

Одним из самых популярных решений для автоматического документирования кода является Mintlify. Этот инструмент умеет генерировать текстовое описание функций, классов, автотестов, создает документацию к пул-реквестам, имеет интеграцию с GitHub и VS Code.

У Mintlify есть безусловные преимущества:

-

Автоматическое формирование читабельных описаний к автотестам;

-

Интеграция с GitHub – возможность генерировать документацию прямо во время PR;

-

Поддержка CLI, позволяющая запускать генерацию в CI/CD.

Но вместе с тем решение имеет и недостатки:

-

Стоимость – от $180/месяц за платную версию. Именно в этой версии доступна большая часть функционала на базе ИИ;

-

Проблемная интеграция с Bitbucket, Jira и Confluence – эти инструменты поддерживаются только через “костыли” и обходные пути;

-

Специфика black-box тестирования в значительной степени игнорируется. Mintlify все же является инструментом, прежде всего, для разработчиков, а не для AQA-инженеров.

Как результат Mintlify – сильный инструмент для команд разработчиков, но для QA он может быть чрезмерно дорогим и ограниченным, особенно в нестандартных стековых условиях (Bitbucket, Jenkins, Jira).

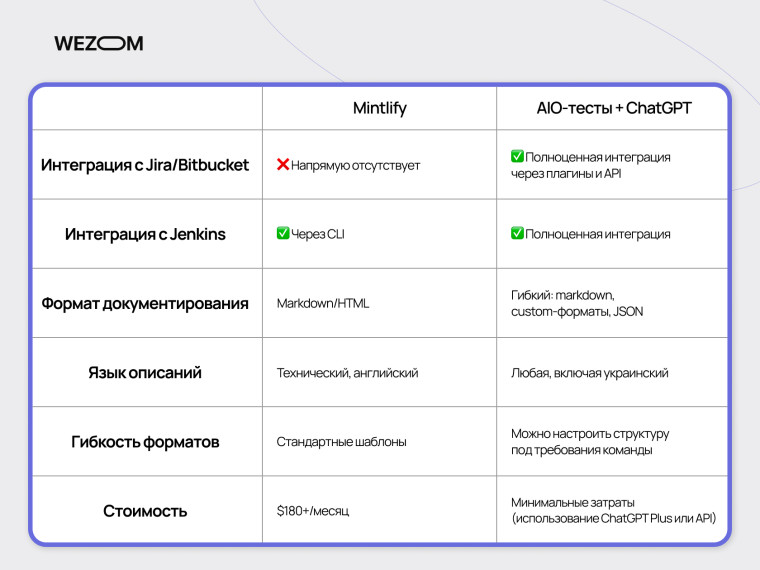

Mintlify vs внутренние решения (AIO Tests + ChatGPT)

Альтернативой продуктам наподобие Mintlify может быть использование внутренних решений. К примеру, интеграция ChatGPT в AIO Tests позволяет автоматизировать создание тестовых сценариев. Такой подход может быть более дешевым и эффективным. В качестве примера давайте сравним подходы по важнейшим критериям для стека WEZOM.

Как итог, наш опыт применения связки AIO Tests и ChatGPT для документации тестирования в реальных проектах оказался положительным и перспективным.

Автоматическое документирование через markdown и CI/CD

Самый простой, но одновременно и самый универсальный подход – генерация тестовой документации в формате Markdown с последующей публикацией через CI/CD пайплайн. Использование markdown в качестве формата обеспечивает гибкость и переносимость документации между разными платформами.

Как это работает? Опишем механизм в двух словах:

- При комите нового автотеста генератор (например, скрипт с ChatGPT API или внутренний плагин AIO Tests) формирует .md-файл с описанием

- CI/CD (например, Jenkins или GitHub Actions) автоматически:

- добавляет документацию к pull request;

- копирует ее в соответствующую wiki/Confluence/страницу проекта;

обновляет changelog или release notes.

Эта формула дает важные преимущества: описание тестов создается вместе с самими тестами, поэтому документация всегда соответствует актуальному коду. Этот механизм легко интегрируется с Bitbucket или Jenkins. Однако для успеха такого подхода требуется отлаженная система генерации .md-файлов и правильная конфигурация CI/CD пайплайнов.

Локальные LLM: безопасность и fine-tuning

Выше мы уже затрагивали вопросы безопасности применения больших языковых моделей. Можно ли доверять код с клиентскими данными облачным ИИ-моделям? Насколько безопасно тестирование с помощью chatGPT и других подобных моделей? Локальное развертывание LLM позволяет снять эти опасения и обеспечить безопасное тестирование в закрытом контуре.

Как обучить собственную LLM

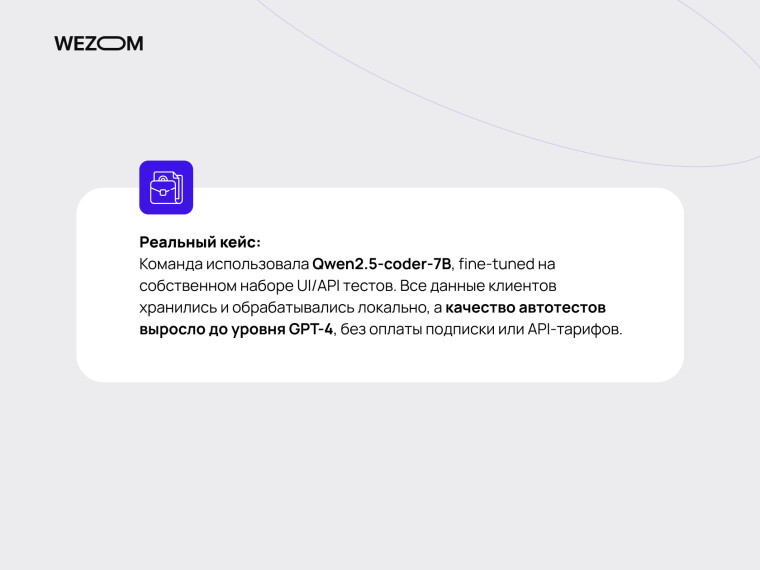

По нашему опыту, одной из лучших моделей для локального использования в QA является Qwen2.5-coder-7B. Это открытая модель, оптимизированная для написания кода, включая автотесты на Python и JS.

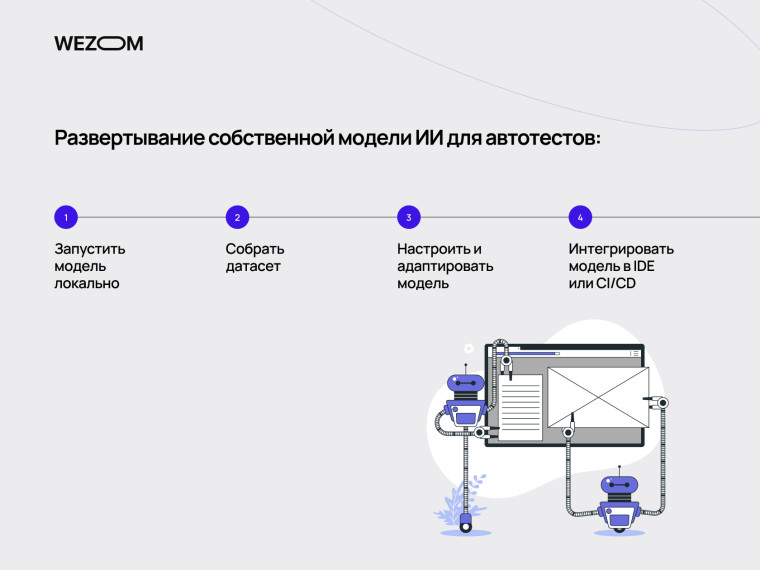

Чтобы превратить ее в вашего внутреннего QA-помощника, нужно:

- Запустить модель локально через Ollama или HuggingFace (об этом ниже).

- Собрать датасет из примеров реальных автотестов вашей компании.

- Настроить и адаптировать модель, чтобы она "изучила" ваш стиль написания, структуру тестов, инструментарий и т.д.

- Интегрировать модель в вашу IDE или CI/CD. Например, через Continue-плагин или REST-интерфейс.

Обученная таким образом модель будет учитывать ваши стандарты, контекст и особенности продукта. И все это – с минимальным риском утечки данных.

Лицензирование, запуск через Ollama, HuggingFace, LM Studio

При работе с локальными LLM важно учитывать вопросы лицензирования и выбора инструментов для их запуска. Различные модели имеют разные лицензии, определяющие условия их использования, модификации и распространения. Необходимо тщательно изучить лицензию каждой модели перед ее использованием.

Кроме того, существует ряд инструментов для запуска локальных моделей.

-

Ollama: Инструмент для запуска и управления LLM на локальной машине.

-

HuggingFace: Платформа, предоставляющая доступ ко многим LLM и инструментам для их обучения и развертывания.

-

LM Studio: Инструмент, позволяющий легко запускать LLM на локальных машинах, с упором на удобство использования.

Выбор конкретного инструмента зависит от технических требований, доступных ресурсов и предпочтений команды разработчиков.

Безопасность тестирования

Почему все больше компаний избегают использования ChatGPT или Claude? Риск утечки данных существует всегда, даже если вендор гарантирует конфиденциальность и имеет сертификаты безопасности. Случаи, когда общедоступная модель воспроизводила фрагменты частного кода, уже случались.

Использование локальных LLM дает полный контроль над информацией:

-

Данные никогда не покидают локальную инфраструктуру.

-

Можно задать whitelist директории или API, с которыми работает модель.

-

Локальное хранение промптов, логов, результатов генерации – без сторонних серверов.

-

Изоляция среды – модель можно запустить на отдельном хосте или VPN-сегменте.

Кастомный подход

Локальное обучение моделей также незаменимо в реализации кастомных сценариев QA, особенно когда речь идет об автоматизации в закрытой среде, адаптации под специфику продукта и использовании в изолированных пайплайнах. Для таких задач подходит не только упомянутая модель Qwen, но и опенсорные LLM DeepSeek и LLaMA.

-

DeepSeek неплохо пишет код "из коробки", но если ее отдельно доучить на качественном датасете, то можно добиться действительно отличных результатов. Как результат, применение Deepseek для генерации тестов – это путь, к которому прибегают все больше команд QA.

-

В то же время модели LLaMA (13B або 34B) – это оптимальный выбор для команд, желающих глубоко кастомизировать свой ИИ: адаптация к внутренней терминологии, fine-tuning на нетипичных датасетах и т.д. В состоянии "из коробки" генерация кода LLaMA не впечатляет, но зато модель предлагает стабильность и производительность.

Обе модели позволяют избежать передачи данных в облако, масштабируются под нужды команды и поддерживают полную кастомизацию – от типа автотестов до специфики стиля кода.

Выводы

Прямо сейчас автоматизированное тестирование переживает очередную трансформацию – под влиянием больших языковых моделей, глубокой интеграции QA с DevOps и новых требований к безопасности.Современные инструменты автоматизации QA уже не просто помогают писать тесты – они анализируют баги, формируют тест-кейсы по описанию требований, запускаются в CI/CD и генерируют качественную документацию. Как не растеряться в новых возможностях и выбрать правильные инструменты QA?

-

Для небольших команд QA и fast-paced стартапов прекрасно подойдут легкие и бесплатные инструменты типа Codeium или Continue с интеграцией в VS Code. Они обеспечивают быстрый и качественный результат с минимальной настройкой.

-

Для средних и больших команд рекомендуется применять Cody или Windsurf – как мощные среды с глубоким контекстом кода, AI-ассистентами и поддержкой нескольких языков тестирования.

-

Для команд с высокими требованиями к безопасности критически важно переходить на локальные LLM: Qwen, DeepSeek, LLaMA и т.д. Они позволяют избежать утечки данных, кастомизируются под внутренние стандарты и легко интегрируются в пайплайны CI/CD.

-

Для тестирования API и автоматической документации не стоит полагаться на дорогие решения, если они не интегрируются в вашу экосистему. Лучше построить пайплайн на базе ChatGPT, AIO Tests и собственных markdown-шаблонах.

Наша общая рекомендация: 2025 – это год перехода от облачных “помощников” к собственным, безопасным, интегрированным AI-ассистентам в QA, которые не только генерируют код, но и понимают контекст проекта, требования бизнеса и специфику командных процессов.

Будущее автоматизированного QA кроется в творческой синергии человека и ИИ. LLM уже сегодня способны на многое, но именно человек определяет планку качества, риски и ценность тестов. Самый эффективный подход – это сильный AI в руках внимательного QA-инженера. Машины не будут заменять людей – они будут давать новые возможности.